第1回 デジタルオーディオの基礎知識

文●三島元樹

作曲家/アーティスト/エンジニア。総合音楽プロダクション STUDIO MONOPOSTO主催。10年ほど前までは映像制作会社でサウンドデザイナーとして、ゲームのTVCMや店頭用PVなどの音作りを担当。その後独立し現在は映像向けの楽曲制作や音楽レコーディング、自身のアーティスト活動、そして昨年秋より「おまかせMA」というオンラインMAサービスも開始するなど、音に関することを幅広く手がけている。

圧縮によって失われた

データは元に戻らない

みなさま、はじめまして! 今号から連載をさせていただく三島元樹と申します。この連載では、映像制作をするにあたって必要となる「音」に関する基本的な知識を軸に、ちょっとしたノウハウや、音楽を含めた音全般に関することなど、ざっくばらんに、なるべく小難しいことを省いて分かりやすくお届けできればと思っていますので、どうぞよろしくお願いします!

さて、記念すべき第1回は【デジタルオーディオの基礎知識】と銘打ってお話をしましょう。ひとくちにデジタルオーディオと言っても、その種類は様々。その中でも主なものをまとめてみました。

【フォーマットの種類と特徴】

◉非圧縮フォーマット:リニアPCM(WAV、BWF、AIFF)

→デジタルオーディオとして最も基本的なフォーマット。BWFはメタデータを含めることが可能な業務用WAV。

◉非可逆圧縮フォーマット:P3、AAC(MP4)、MQA など

→主に一般用途に使われるフォーマット。多くの場合、非圧縮データの情報を間引いて圧縮する。データ容量は小さくなるが、そのぶん音質も劣化する。MQAは、データ的には非可逆だが、音質的には可逆…むしろ良くなるという注目の新フォーマット。

◉可逆圧縮フォーマット:FLAC、ALAC など

→主に高音質リスニングに使われるフォーマット。圧縮前とまったく同一の音質を再生できるという可逆性を持っているが、データ容量的にはあまり小さくはならない。

◉その他:DSD(DSF、DSDIFFなど)

→1bitオーディオとも言われているが、リニアPCMのようなマルチbitオーディオとは根本的に概念が異なるので、WAVの「24bit」などとは同列で比べられない。現在、最も高音質なフォーマットのひとつだが、編集ができないという弱点がある。

どうでしょう? 馴染み深いものから、初めて見るものなど様々だと思いますが、この中で、現在の映像制作に最も適しているものは「リニアPCM」です! その理由は以下の通り。

1.非圧縮フォーマットなので音質的に優れている。

2.切ったり貼ったりなどの編集ができる。

3.世界的に最も普及しているデジタル音声フォーマットなので、あらゆる機器、ソフトウェアで扱える。

MP3やAAC(MP4)などは圧縮フォーマットなので、少なからず音質的なロスがあります。圧縮率によっては、パッと聞きではあまり分からないかもしれませんが、映像制作や音楽制作などのように加工を前提とする素材としては不向き。FLACやALACなどは、音質的に劣化しないロスレス圧縮フォーマットですが、大した容量削減にもならず、ネイティブで(他フォーマットへの変換なしで)編集できるソフトがないので、やはり制作には不向きです。DSDは、1999年登場のSACDで採用され、現状で最もアナログに近いデジタルオーディオと言われており、音質的にもリニアPCMとは違ったなめらかな質感を持っています。ここ数年でやっと注目されてきたフォーマットですが、仕組み上、そのままでは編集ができないという弱点があるため、制作の現場では主に音楽の一発録音(編集なしの全編通し録音)やミックスダウン(複数の音声を1つのステレオ音声またはサラウンド音声にまとめること。トラックダウンとも言う)の時のマスターレコーダーとして利用されることが多いです。ということで、映像制作には「リニアPCMのほぼ一択」ということがお分かりいただけたかと思います。もちろん、圧縮フォーマットでも聴感上で違和感がないのであれば使用してもOKだとは思いますが、非常用と考えてください。やはりクオリティを求めるならリニアPCMを使ったほうが良いでしょう。圧縮によって失われたデータは元に戻りません。作品のマスターとなるファイルは、なるべくクオリティの高いものにすべきです。ちなみにWAVとAIFFのどちらを使うかですが、音質的にはほぼ同じです。ただ、互換性を考えると、Macユーザーだとしてもデータの受け渡しにはWAVを使うのが安心かもしれません。

「16bit/44.1kHz」は

CDクオリティの最低ライン

では、リニアPCMについてもう少し掘り下げてみましょう。リニアPCMのスペックを表すものに「量子化ビット数」(ビットデプス)と「サンプリング周波数」(サンプリングレート)というものがあります。「16bit/44.1kHz」なんて表記を目にしたことありますよね? これは、元の音声(アナログ)を16bit(2の16乗 = 65,536)という音量的段階で、1秒間に44,100回のサンプリング(デジタル化)を行なっているという意味です!…と言っても「なんのこっちゃ?」だと思うので、映像に例えながらポイントをまとめてみました!

【量子化ビット数(Bit Depth)】

◉単位:bit

◉オーディオ:音量に関わる解像度。数値が大きいほど小さな音も忠実に再現できるようになり、そのぶん理論値的なダイナミックレンジ(音量の最大値と最小値の比率)は広くなる。制作で使われるのは主に16bit、24bit、32bit float。

◉映像に例えると…:概念的には階調のビット数に相当する。感覚的には、映像におけるダイナミックレンジとほぼ同じ。レンジが広いほど白飛び、黒潰れせず、階調豊かな表現が可能。

◉備考:MP3などの圧縮フォーマットには量子化ビット数の概念はない。

◉量子化ビット数イメージ図

縦軸(音量)にマス目を切ったときに、その1段に満たない音量の変化は再現できず、ノイズになってしまう。つまり、マス目が細かければ細かいほど、小さな音量も正確に再現できるようになる。よく使われるビット数における実際の段階数は以下の通り。

・16bit→65,536段階

・24bit→16,777.216段階

CDクオリティの16bitより、ハイレゾと言われる24bitのほうが、遥かに細かく音量の変化を再現できていることが分かる。言い換えると、16bitよりも24bitの方が「ダイナミックレンジが広い」ということである。

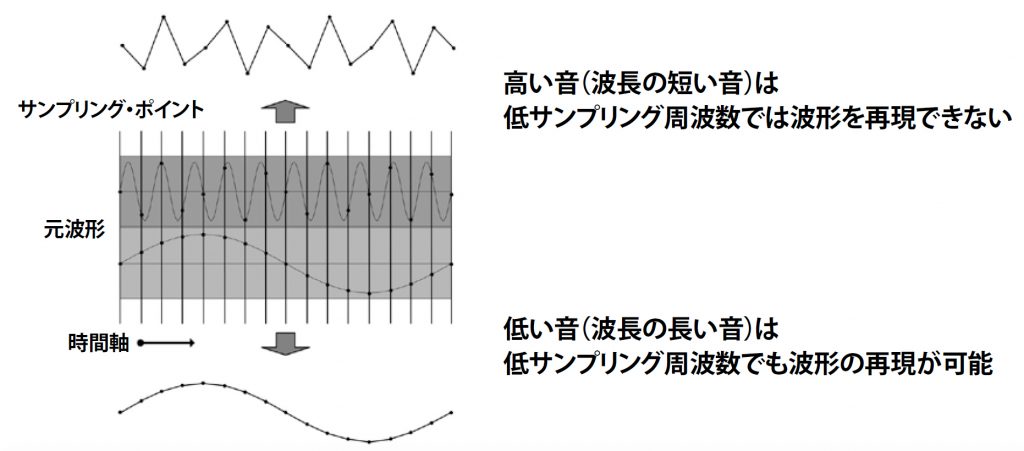

【サンプリング周波数(Sampling Rate)】

◉単位:Hz

◉オーディオ:時間的な解像度。再生可能な周波数レンジに関わる。レートが低いと高音域が正しく再現されない。レートが高くなるにつれ、可聴範囲以上の高周波まで再生可能になる。制作で使われるのは主に44.1kHz、48kHz、96kHz、192kHz。

◉映像に例えると…:時間的な解像度という点では、フレームレートに相当する。レートが高ければ、よりなめらかな動画となる(音の場合、なめらかさというよりは高音域の再現性として認識される)。

◉備考:実際に再生できる周波数の上限はレートの半分。例えば、レートが96kHzの場合、48kHzまで再生可能

◉サンプリング周波数説明図

映像に例えると、なんとなく理解していただけるのではないでしょうか? 2018年現在、常用できる最低ラインのクオリティは、CDが採用している「16bit/44.1kHz」だと思います。各数値がこれよりも低くなっていくと、聴感上でも分かるくらいにどんどん破綻してきます。bit数が小さいと小さな音はノイズになるし、サンプリング周波数が小さいと折り返しノイズ(デジタル化で必ず発生するノイズ。音のモアレ現象)が可聴域にまで下りてきて耳障りになります。そして、サンプリング周波数の値の半分が、実際に記録/再生される周波数の上限だということを覚えておいて下さい。つまり「44.1kHz」の場合、実際に記録/再生されるのは約22kHzまでということですね。人間の可聴範囲は20Hz~20kHzまでと言われているので、スペック的には充分な数値です。この可聴範囲上限の2倍にサンプリング周波数を設定することで、折り返しノイズを可聴範囲外に追いやり、さらにデジタルフィルターでカットすることによって、耳障りなノイズを排除しているのがCDクオリティというわけです。このことからも「16bit/44.1kHz」が最低ラインというのがお分かりいただけると思います。

マスターとなるファイルは

高品位である必要がある

とは言っても、低ビット、低サンプリング周波数でどう音質が変わるのか、実際に体験しないと分かりにくいでしょう。というわけで、聴き比べ用のファイルを用意しました!

●「16bit/44.1kHz」のオリジナル素材(サンプル1)

●オリジナルを「8bit/44.1kHz」にしたもの(サンプル2)

●オリジナルを「16bit/11.025kHz」にしたもの(サンプル3)

※音声サンプルダウンロードはクリックするとダウンロードが始まります。楽曲の著作権はすべて三島元樹に帰属しています 。余談ですが、今回使用した楽曲は僕のオリジナル曲『キミ 想フ ヨルニ』をピアノソロで録音したものの一部です。ピアノトリオで収録したものなど数バージョンが、iTunes Store、Apple Music、Spotifyなどで配信されておりますので、気に入っていただけた方は各配信サービスで「三島元樹」で検索してみてください!(笑)。

いかがでしょうか? 8bitの音は、暗騒音(背景ノイズ)や音の消え際などの小さな音がノイズになっているのが分かると思います。また、11.025kHzの音は、キンキンとした耳障りな音(折り返しノイズ)が入っていますね。どちらの音も、制作はおろか鑑賞にも堪えないものであるのは明白。音楽制作では、表現のひとつとして、意図的にこのような劣化させた音を使うこともありますが、それでもすべての音が全編通してこれでは、さすがに聞いていられないでしょう。CDというデジタルメディアが「16bit/44.1kHz」というスペックになったのは、こうした聴感上のクオリティと、データ容量の折り合いが良かったからなんです。

さて、CDクオリティが最低ラインというのが分かったところで、では実際の制作ではどうなのか? というのが気になるところだと思います。実は、映像作品にしろ音楽作品にしろ、最終的に圧縮ファイルやCDになるとしても、制作時はもっとハイクオリティな状態で作っています。みなさんは「ハイレゾ」(Hi-Res)という言葉を耳にしたことがありますよね? 「ハイレゾ」=「High Resolution」…つまり「高解像度」という意味。このハイレゾの定義は【CDよりハイスペックであること】となります。CDのスペックは前述の通り。これよりハイスペックということは、最低でも「24bit/44.1kHz」ならばハイレゾと言えるわけです(16bitはハイレゾとは認められない)。しかし、こんな中途半端なスペックは、まず使われません(苦笑)。

結論から言ってしまうと、映像制作においては「24bit/48kHz」で制作するのがベストだと思います。根拠としては、劇場映画を含め、多くの映像メディアがこのスペックを採用しているからです。もちろんYouTubeなどの動画配信サービスでは圧縮音源になってしまいますが、前述の通り、マスターとなるファイルは高品位である必要があります。音楽制作の現場では、すでに「24bit/96kHz」が当たり前になってきていますが、映像の場合、ファイル容量やマシンにかかる負荷の問題などを考えると「24bit/48kHz」が妥当ということです。

次回は高音質なデジタルオーディオを扱うための機材関係の内容をお届けする予定です!

●この記事はビデオSALON 2018年4月号 より転載