ソニーから発売されている誰でも手軽にモーションキャプチャーができる『mocopi』。VTuberやVRChat界隈ではその手軽さから多くのユーザーの支持を集めている。前回はmocopiをアニメーション制作に活用する大学生の事例を紹介したが、今回は3DCGアニメ制作の一線で活躍するプロの目から見てmocopiはどう映るのか? 3DCGでのセルルックアニメを得意とする映像制作チームHurray! の代表・ぽぷりかさんに実際にmocopiを体験してもらい、そのインプレッションを伺った。

文●永渕雄一郎 取材・構成●編集部 萩原 協力●ソニーマーケティング株式会社

映像制作チームHurray!と3DCGアニメ

――Hurray! のチーム結成は2017年とのことですが、最初に制作した映像作品も3DCGアニメだったんでしょうか?

最初は2Dアニメから始めましたが、やっていくうちに1秒間のアニメを作るのに8〜12枚の絵を描くことの大変さに気づき、もう少し効率的なやり方ができないかなと思っていました。「ほぼ同じような絵を何枚も描く意味ってなんだろう」「やっぱり3Dでできたらいいなあ」と考えるようになっていきました。それで、だんだん3Dを取り入れていくようにして、最初は背景やプロップから、次はモブキャラクター、最後はメインキャラクターも3Dで、という風にだんだんと3D側に寄っていくような形にしました。その後、フル3Dで映像作品を初めて作ったのが、ヨルシカさんの『だから僕は音楽を辞めた』のMVでした。

もちろんおはじきの2Dアニメもあったので、3Dだけに専念というわけでは全くなかったです。例えば、2週間しか期間がない仕事や6秒間の尺しかないようなアニメの仕事に対して、3Dでキャラクターを1体起こすだけでも1カ月かかってしまうので、それもフル3Dでというのは非効率です。3Dも2Dもあくまで武器のひとつに過ぎず、作りたい映像や条件に合わせて何を使うかを選んでいきます。

モーションキャプチャーを取り入れたきっかけと変遷

――映像作品にモーションキャプチャー技術を取り入れたのはいつ頃からですか?

1番最初に取り入れたのは、ツユさんの『過去に囚われている』という楽曲のMVでした。

このときはバレエダンスの動きを絶対に入れたかったんですよ。でも、バレエをやったこともない自分がその動きを手付けするのは無理だろうなと思っていました。最初は、バレエの動きみたいなものが3Dデータでいくつか公開されていたのでそれを使おうと思っていたんですが、とてもじゃないけれど組み合わせられないなと思って。 それで、「モーションキャプチャーを使おう」という判断をして、知り合いの伝手を使い、長いことバレエダンサーをやられている方を見つけてきて、協力してもらうという形にしました。実際に使ってみて、「モーションキャプチャーを取り入れることで、こんなに簡単にアニメーションが作れるのか」と本当に革命的だったんです。それで、「この技術はぜひ今後も取り入れていこう」と思い立ったんですが、以降の作品ではなかなかモーションキャプチャー自体を使いこなせませんでした。

――それは、なぜでしょうか?

『過去に囚われている』のときはバレエダンサーの方にダンス部分をやってもらったんですが、次の作品『モナーク/Monark』のオープニング映像ではモーションキャプチャーを使って、僕がアクターをやったんですよ。これが非常に難しくて。バレエダンスは踊り自体が格好いいから、踊っている方が専門のアクターさんがどうとかはあまり関係なく格好よく決まるんです。ただ、普通の日常演技をやるとなるとそうはいかなくて。当時は素人の自分がアクターをやるからいけないんだと思っていたんですが、今では普通の日常演技はプロのアクターさんでもそこまで大きくは変わらないのではと思っている部分もあります。八月のシンデレラナイン MV『Generic Riot!!』のときも知り合いの野球をやっていた子にアクターを頼んで撮影したものの、スライディングをすればモーションはぐちゃぐちゃになるし、バットを振るモーションなんかも再現が難しくて、結局「ほとんど手付けじゃないか」と本末転倒な事態になってしまっていました。結果的に、「あれ? モーションキャプチャーってあんまり使えないかも…」という状態が少し続いてしまっていたんです。「自分のやり方が撮影の方式に合ってないのかな」となかば諦めていた部分もありました。

――専用スタジオも使うなると制約もありそうですね。

そうなんですよ。僕は実写撮影の経験も多少あるんですが、やっぱり撮影ってチームでやるもので、自分で集めてきて作り上げたチームではなくて、その場ではじめましてのスタッフさんとはあまり上手く撮れないんです。遠慮もしてしまうし、気も使う。すごくやりづらいんです。モーションキャプチャーはこういうものだとは思いつつ、もっとチーム一体で良いものを撮ろうとする形はないかと模索しました。結果としては高精度のキャプチャーを捨ててトライアンドエラーのやりやすさや独自のワークフローを優先し、自分たちだけで撮影ができるように磁気式のモーションキャプチャデバイス「Perception Neuron Studio」を自分たちで購入するという流れになりました。Hurray! で手がけた最新の3DCGアニメーション映画『数分間のエールを』では、 Neuron Studioを使用したモーションキャプチャーをふんだんに活用しています。

モーションキャプチャーの方式と代表的な製品

――磁気式のモーションキャプチャー精度は別の方式のデバイスと比べてみてどうですか?

精度だけで見るなら、もちろん光学式のViconやOptiTrackのほうがいいと思います。光学式は複数台の専用カメラをたくさん設置して、マーカーがついたスーツを着て収録します。なかなか個人でこの仕組みを導入するにはハードルが高いため、モーションキャプチャーの専用スタジオで収録するケースがほとんどです。その点、磁気センサーやIMU式はセンサーとその動きを検出するPCだけを用意すれば収録ができるんですよね。例えば、磁気センサーのスーツのサンプル映像にはスカイダイビングをしているものもあるんですが、そういったことは光学式では難しいんです。外を走り回っても手軽に撮影ができることが磁器式やIMU式の優れている点と言えるかと思います。

| 方式 | 主な製品 | 特徴 | |

| 光学式 | VICON、OptiTrackなど | 専用カメラと、光の反射率が高い球型マーカーを使用して計測をするシステム。複数のカメラが必要で、モーションスーツを着用。専用のスタジオ | |

| 慣性式 | 磁気センサー使用 | PerceptionNeuron Studioなど | センサーとPCがあれば使用できる。近くに金属があるシチュエーションだとうまく精度が出ないこともある。 |

| 磁気センサー不使用 | mocopi、XSENSなど | 加速度・角速度センサーを搭載しており、動きの慣性を検知してモーションキャプチャーする仕組み。磁気の影響を受けずどこでも使えるのはメリット。 | |

ソニーのモーションキャプチャーデバイスmocopiを体験する

モーションキャプチャーに必要なのはこれだけ

Blenderで作った3Dモデルをmocopiに読み込む方法

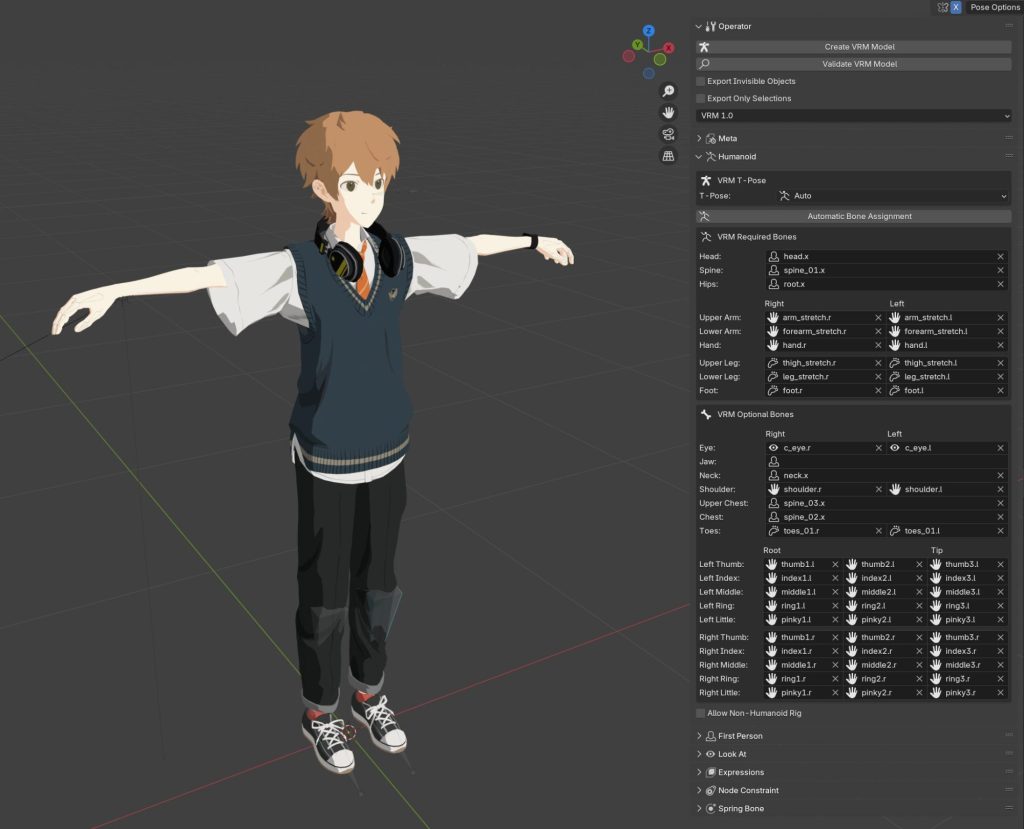

映画『数分間のエールを』主人公の彼方くんをmocopiに召喚。Blenderで作った3Dモデルをmocopiに読み込むにはモデルデータをVRM形式にする必要がある。VRMに書き出すには、VRM Add-on for Blenderというアドオンを使用した。もともとBlender用に作ったモデルなので、mocopiに書き出したときにリグやシェーダーなどが崩れてしまうこともあるので、修正が必要。

6つのセンサーを取り付ける

頭、腕、腰、足首といった人間の軸となる主要部分に計6点のmocopiを装着する

mocopiは3Dアニメーションビギナーの方におすすめ

――今回改めて体験していただいて、『mocopi』にどんな印象を持ちましたか?

mocopiはIMU式なので、気軽に使えるのがすごくいいですね。ただ、IMU式や磁気式の場合、長時間収録をすると、だんだんとキャリブレーションがズレてきてしまうのがネックではありますね。光学式の場合は、カメラから見た基準点を撮るだけなのでズレが起きず、長時間撮影でもいけるんですよ。僕らの場合は基本的に長時間撮影が必要ないので、カットごとにキャリブレーションをすれば特に問題はないんですが、1カットごとにキャリブレーションを挟むと撮影も長くなってしまい集中力も切れていくので、結局のところできれば連続撮影はできたほうがありがたいですね。

――mocopiはどんな方に向いている製品だと感じましたか?

映像制作をこれから始めてみたいという方にとって、mocopiの選択肢があるのはすごくいいことだと思いました。いざ3Dモデルができて「じゃあカメラを置いて演技してみましょう」という部分を全て手付けでいきなりやるのは大変なので、一旦mocopiを使ってモデルを動かして雰囲気を掴む、といった使い方においてはとても優れている製品だと思いますね。また、磁気を使っていないという点もユーザー目線からすると非常に手軽ではあります。僕らのように床を底上げしたりしなくていいですし、本来であればアクセサリーをつけながらモーションキャプチャーを撮るなんてことも絶対にあり得ないんですが、mocopiであればそれもできるなど、このツールだけで手軽に完結している点は本当に素晴らしいと思います。

一方、僕のようにすでにNeuron Studioのような別のモーションキャプチャーデバイスを持っている場合、自分のワークフローを完遂するための代替製品にできるかというと精度的に現状ではまだ難しいのかなとも感じました。自分たちのワークフローの場合、やはり精度が安定しているかどうかが非常に大事なので、例えばモーションキャプチャーの精度が低く、足が地面からズルズルと滑ってしまっていたら、後からそれを直す作業は本当に大変です。全くクリエイティブでもないですしね。

3Dキャラクターと人間ではプロポーションが大体違うので、普通に演技してもズレは生じてしまうんですが、それは後でキャラクターの体型に合わせてポーズとしてつけなおせば問題ないんです。例えば腕組みをしてるポーズを撮影して、プロポーションの差のせいでキャラ側の腕が綺麗に組めてなかったとしても「腕組みをしてて偉そう」な印象さえ収録出来ていればなんとかできる。でも「実際どんな演技をしていたのか分からないほど体勢が違う」とか「腰がずっとビクビク動いてる」とか、そういうデータが撮れてしまうと難しいです。そういうノイズを直す作業はすごくコストがかかるし、そこから直すならもう最初から手付けでアニメーションをつければいいんじゃないの? とも思う。

また、Neuron Studioの場合だとキャラクターが立った状態から座って、そのまま演技をしても違和感がなく収録ができるのですが、mocopiの場合そういう動きをしたときに、精度が不安定な部分がまだあるようでした。細かな部分の精度向上が課題なのかなと思います。例えば、キャラクターが座ったときに、さっき話したように精度の問題で腰がユラユラ動いていたら、座っているようには見えません。でもそれを直そうとして腰の骨をピタッと止めてしまうとそれはそれは違和感が出てくる。実際座っていても上半身を揺らせばお尻は多少動くからです。そういう、物理的に人間の体はそう動くよね、という部分がちゃんと収録出来て、後はキャラクターとしての演技を良くする部分に時間が使える精度になってくれると、自分たちのワークフローの中にもmocopiを落とし込めるようになるんじゃないかなと感じました。

――mocopiを使用する制作会社では、mocopiでディレクターがVコンテ段階でラフな動きを作ってから、それをもとに3DCGアニメーターのスタッフが本番用の映像を作る取り組みもしているそうです。

その使い方はすごくいいですね。分業制のアニメスタジオであれば、プリビズを作った後でちゃんとした本番データが入ると思うので、mocopiで1度仮撮影をしてからそれを参考にして本番を撮り直すという使い方は製品に合っている気がします。僕の場合は、少人数ゆえに後で本番用データを撮り直したりする時間がないので、最初に撮影したデータを良くするという方法しか取れません。なので最初のキャプチャーデータにある程度の精度がどうしても必要になる。だから現状だと、どうしても中途半端になってしまうんですが、mocopiの手軽さの利点を活かせる制作体制はいろんな場所にきっとあると思います。

――VTuberなど動画配信者向けの「上半身集中モード」も試していただきましたが、いかがでしたか?

上半身集中モードだと精度がかなり上がるし、動きのニュアンスも伝わるので、VTuberの方などが使うには本当にこれでもう問題がないレベルなんじゃないかと感じました。その界隈の方々からはとても好評なんじゃないでしょうか? 僕もインタビューやウェビナーなどを行う際にはあまり顔を出したくないので、いつもアイコンだけ顔に貼ってもらっているんですが、いずれどこかでこのモードとVRMを使ってやりたいなあ(笑)。

上半身集中モード

――最後に、改めてmocopiを体験してみた感想を聞かせていただけますか?

mocopi自体は以前にも使わせてもらったんですが、モーションキャプチャーとしての新しい可能性を大きく感じさせるアイテムだと思います。細かな動きの精度やニュアンスの表現にはまだ課題がありますが、何より他の製品と比べて手軽なので、mocopiを入り口に3Dアニメーションをスタートさせる分には優れた製品だなと思いますね。コレ例え下手かもしれませんが、格闘家に憧れて「自分もああなりたい!」と思ったとき、本来であれば腹筋とか筋トレみたいな地味な部分から始めるべきなんだけど「とにかくすぐに戦ってみたい!」という人のためにあるツールというか。でも一回戦って見たことで見えてくる景色があるし、筋トレはその後で始めても別に問題ないんですよね。

先ほども言いましたが、3Dモデルを作ってはみたものの「ここから先、全部自分で動かすのか…」と思うと大変じゃないですか。そういうときmocopiを使うことで、「こういう雰囲気で動くんだ」というのをすぐに確認できるし、全てを手付けでやるよりも遥かに早いので、初めてモーションキャプチャーを扱うビギナーの方にはおすすめできる製品だと思います。将来的には、僕のようにすでに何らかのモーションキャプチャーデバイスを使用して制作しているような人にとっても、代替になるような機能をmocopiが搭載してくれたらすごくいいなと思いますね。

――本日は貴重なお時間をいただき、ありがとうございました。

●mocopiの製品情報