2024年11月13日(水)から15日(金)の3日間にわたり、国内最大のメディア&エンターテインメント機材展「Inter BEE 2024」が催された。今回で60回を迎えた本イベントは、新たに映画制作技術にフォーカスした特別企画『INTER BEE CINEMA』を実施。本稿では、その企画セッション「撮影現場のアプリ利用 2024 〜『ゴジラ-1.0』で使用されたAR Finder、NHK『100カメ』アプリ開発について」をレポートする。

TEXT & PHOTO ● NUMAKURA Arihito

『ゴジラ-1.0』のロケハンに、「AR Finder」が導入された理由

本セッションに登壇したのは、シネマトグラファーとしての活動と並行して、実写撮影を効率的に行うためのアプリなどの開発も行っている倉田良太(合同会社9パーセント)。聞き手は、ディレクターやシネマトグラファーとして活躍している髙橋 遼氏が務めた。なお両氏とも日本映画撮影監督協会(JSC) に所属している。

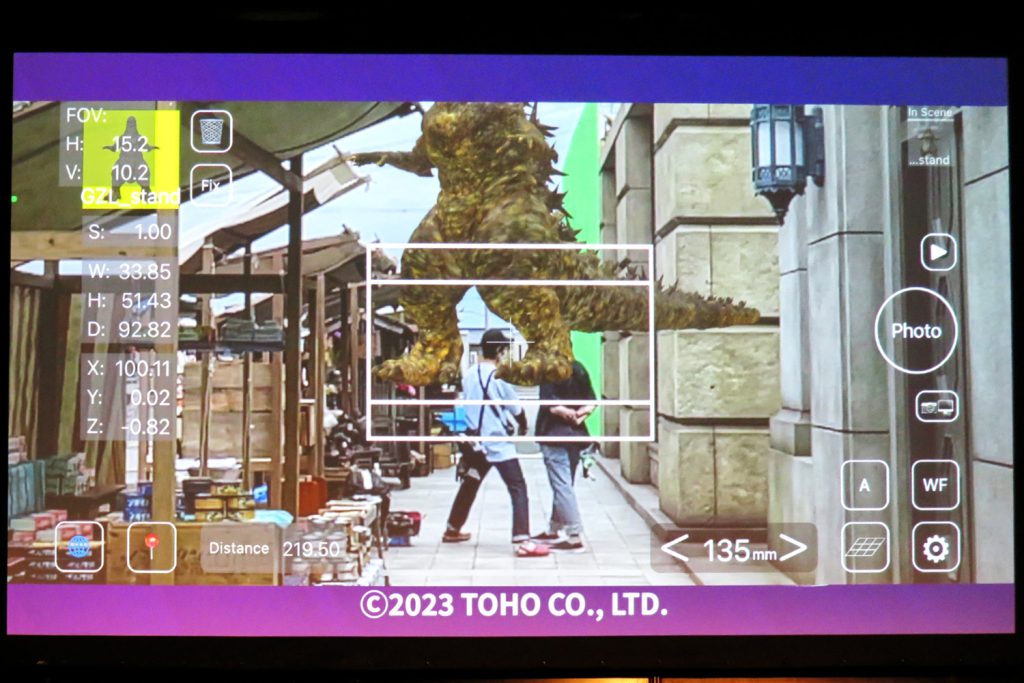

読者の中には既知の方もいると思うが、倉田氏が開発した代表的なアプリに「AR Finder」というiPhone / iPad用アプリがある。その名の通り、CGキャラクターなどの3Dオブジェクトをアプリに読み込み、現実世界に配置したときの見え方を確認したり、そこから得られた3D空間情報を取得するといったことができるものだ。

実は「AR Finder」を開発するきっかけは、当時NHKに所属していた松永孝治VFXスーパーバイザーからの依頼だったという。

その後、NHKスペシャル『恐竜超世界』(2019)のロケハンでAR Finderが利用されたことが本作のメイキング記事などを通じて知られていったのだが、『ゴジラ-1.0』(2023)でもAR Finderがロケハンで導入されたことで本セッションが実現したようだ。

あくまでも本業はシネマトグラファーである倉田氏がアプリを開発し始めたきっかけは? そして様々なアプリを開発し続けているモチベーションはどこから来るのか? そして、今後のアプリ開発の展望などが、各種アプリのデモを交えて語られていった。

倉田良太氏(以下、倉田):

(アプリ開発の動機について)ひと言で説明するのは難しいのですが(苦笑)、何かを作っていたい性分なんですよね。仕事でも趣味でも。

実写撮影が本業ですが、全体的なスケジュールの兼ね合いなどで空き時間ができるんです。そのときの過ごし方として、アプリ開発が定着している感じですね。

あとは、アプリって物理的な場所の制約を超えていくというか、App Storeなどで公開すると、インターネットを通じて勝手に広まっていくことが好きというか、やりがいにつながっていると思います。

——まずは、AR Finderが『ゴジラ-1.0』で採用された経緯が披露された。

ロケハン時に全高50.1mという巨大な怪獣の大きさを正確に把握するための手段を探していた渋谷紀世子VFXディレクター(白組)が、夫でもある松永氏にAR Finderのことを教えてもらい倉田氏へ協力を求めたことがきっかけだったという。

当然ながらそのときは『ゴジラ-1.0』という作品名は伏せられていたそうだが、渋谷氏より本番の撮影で使用するシネマカメラの仕様やレンズのミリ数などをAR Finder上で入力すると、そのアングルでの見え方をシミュレーションできるようにしてほしいといった要望を受けて、カスタマイズを施したAR Finderを提供したそうだ。

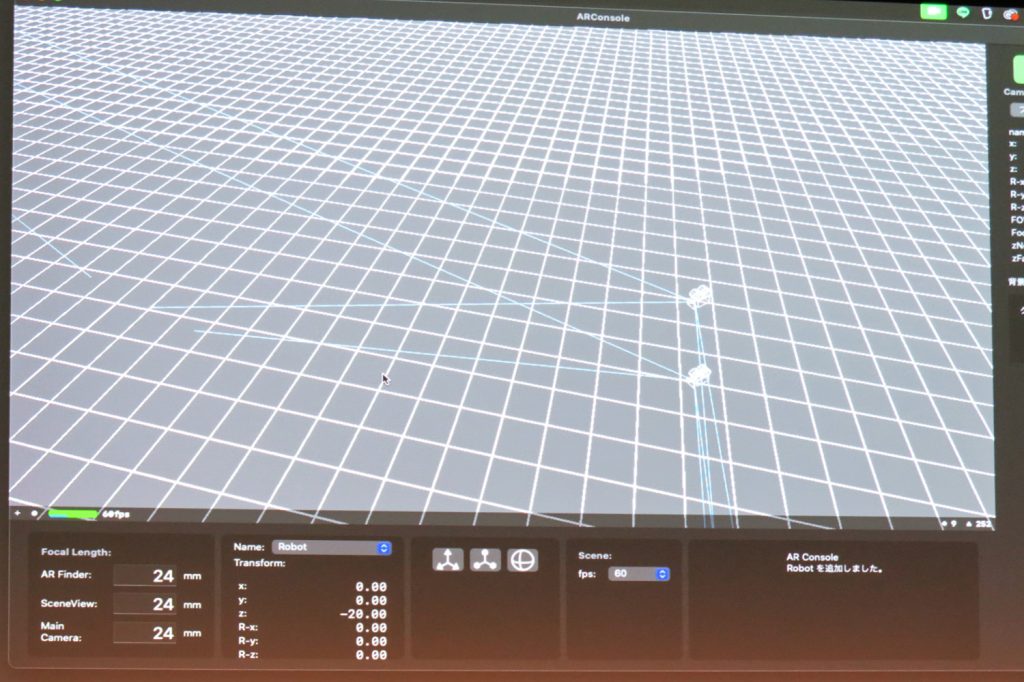

撮影カメラと併用する想定で開発した「AR Console」

次に紹介されたのが「AR Console」。開発途中のアプリだが、AR Finderの発展形として撮影カメラと併用することによって、ARで表示したCGオブジェクトの撮影カメラでの見え方をよりダイレクトに把握できるようにすることを目指しているという。

NHK番組『100カメ』の撮影用に開発したアプリ

続いて紹介されたのが、「100カメ」アプリ。倉田氏が撮影に参加しているNHKのドキュメンタリー番組『100カメ』からの要望を受けて、開発したものである。

番組名の通り、100台の固定カメラを気になる場所に設置して取材対象となった人々の生態を観察するという内容の番組だが、収録中のカメラを効率的にモニタリングするための手法について相談を受けたことが開発のきっかけだったそうだ。

倉田:

100カメの収録には元々、GoProを使用していたそうです。

僕が関わり始めたタイミングでiPhoneも使われ始めたので、それならモニタリング用アプリを開発してみようと。

『100カメ』では、1回の収録で12〜18時間撮り続けます。余談ですが、24時間以上回すとPremiere Proに読み込めなくなることを知りました。タイムコードが連続して24時間までしか記録できないため、エラーになってしまうんですよ(笑)

——12時間連続で撮影することが至難の業であることは想像に難くない。バッテリーの問題もあるが、カメラアプリが落ちてしまったり、撮影環境に物理的な障害が発生する可能性が高くなる。カメラも100台あれば、RECし忘れるというヒューマンエラーも起きかねない。

そこで倉田氏が100台を同時にモニタリングするためのアプリを開発。実は、クライアントからのオーダーを受けて、アプリを新規に開発した初めての案件になったそうだ。

実用性の高いアプリを開発するためには?

セッション終盤では、来場者に向けて実写撮影の現場で利用できる2つのアプリが紹介された。

まずは「NowTime」。これは、現在の時刻と日付を表示して、複数のカメラのロール頭にタイムコードの代わりにその情報を記録するためのアプリである。

開発のきっかけは、タイムコードを入れることができないカメラが現場で使われる機会が増えてきたことだという。また、iPhoneにインストールされている時計アプリは端末ごとにズレが生じやすいことも開発する後押しになったそうだ。

NowTimeは、アプリを起動すると同時に共通のサーバーに正確な時刻を取得する仕様になっているので、複数台のカメラで同時収録した素材を編集する際に重宝するわけだ。

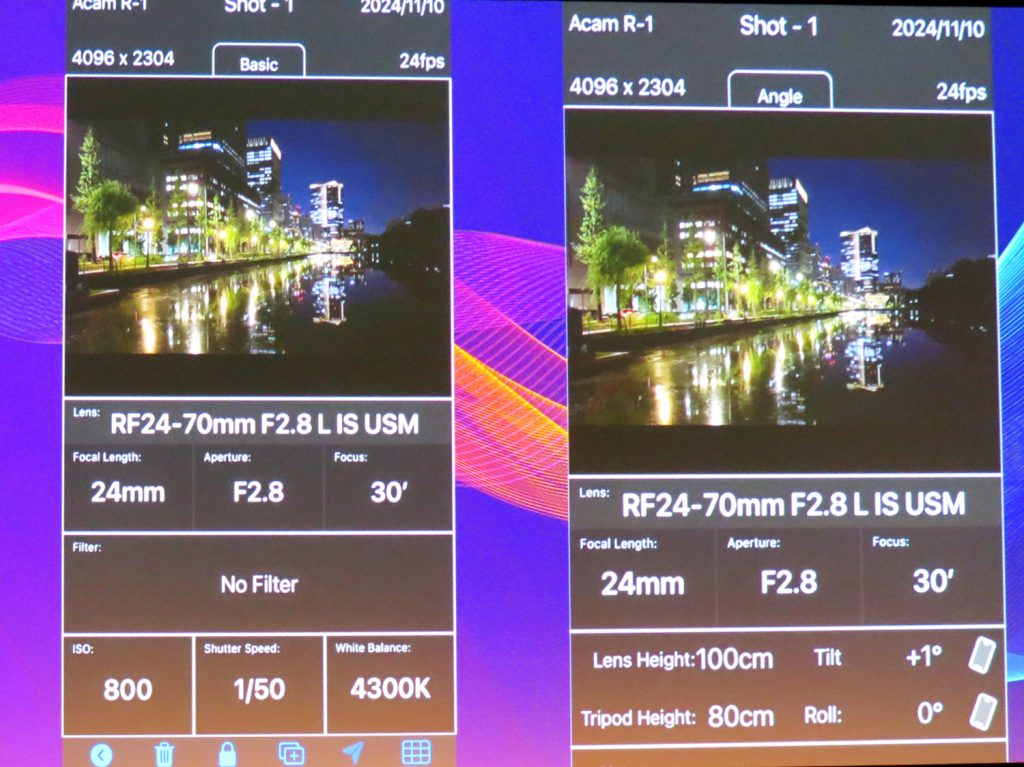

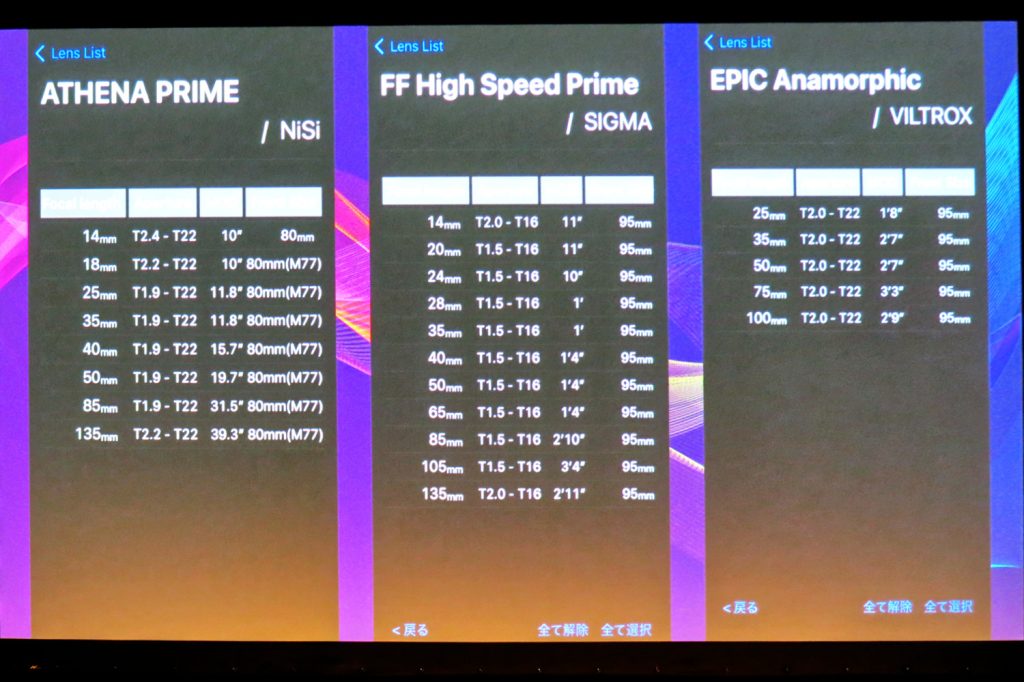

もうひとつは「ShotsData」。こちらはプロの映像制作現場向けに開発したものであり、<1>撮影現場で、そのショットの情報を記録、<2>撮影部をはじめ、全スタッフで共有、<3>作品の撮影データを、半永久的に保存という3つを目的にしている。

倉田:

ShotsDataは、2016年に初期バージョンを公開しました。これまでに開発したアプリの中で2番目に古いもので、実写撮影を本業とする僕にとって大切なアプリです。

できるだけ多くの人に使ってほしいので無料でも使えます。ぜひ試してください。

——無料版は、3プロジェクトまで、1プロジェクトで登録できる上限は50ショットという制限があるものの、MVなどの短尺コンテンツであれば事足りるだろう。

倉田氏のアプリ開発では、ユーザーがどのような目的で利用するものなのかが明確であり、それが開発の根幹になっている。

倉田:

テクノロジー自体は日進月歩なので、一定期間が経つとどうしても古くなっていってしまう。だからこそ、テクノロジーに振り回されるのではなく、斬新な発想や、その人ならではの感性を補助するかたちでテクノロジーを利用することが大切だと思っています。

機械に使われる感じは好きじゃないですし、これからもユーザーの使いやすさにこだわったアプリ開発をしていきたいですね。