第4回「Google JUMPシステムで3DVR映像制作日記」

写真・文●染瀬直人

※この連載はビデオSALON2017年2月号より転載

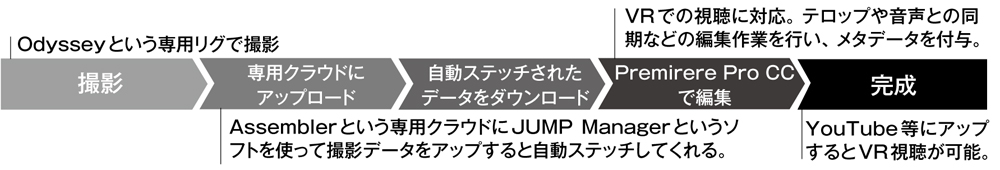

GoogleのVRコンテンツプラットフォーム「JUMP」によるVR制作のワークフロー

国内最大の国際放送機器展Inter BEE 2016が、昨年の11/16~18まで幕張メッセで開催されました。筆者はインテル×アドビ共同ブースでVRに対応したPremiere Pro CC 2017のプレゼンテーションで連日ステージに登壇しました。

アドビシステムズからのリクエストは「立体視の360度実写VRをテーマにして、その魅力を作品を通じて紹介してほしい」ということ。しかし、3D撮影機能を実装するVRカメラはまだ限られています。今回のアドビプロジェクトでは、ノキアのOZOやiZugarを紹介しながら、GoogleのJUMPシステムをメインに使用しました。

撮影場所は増田セバスチャン氏プロデュースによる怪獣の体内をイメージした原宿のカフェ「KAWAII MONSTER CAFE」をはじめ、3D映えする空間を重点に選定しました。また、これからの実写VRを追求する上で、もう一つの重要なテーマが空間音声です。これを実現するために同じく原宿の「CANDY A GO GO」というとても内装の凝ったキャンディ・ショップで複数の店員さんに出演してもらったり、「Pepperアトリエ秋葉原 with SoftBank」で人型ロボットPepperをたくさん配して、全方位から音声が飛び交う状況を設定しました。

16台のGoPro HERO4を円周上に配置したリグOdysseyで撮影

JUMPはGoProのHERO4を16台円周上に配置したリグ「Odyssey」を使用して撮影します。Odysseyは現状ではまだ出荷台数が少なく、使用するためにはGoogleとGoProの審査が必要です。プライマリーカメラから、シャッターはもとより、各種設定をその他のすべてのスレーブカメラへ連動させることと、ゲンロックで完全に同期して撮影する仕組みは6台用のリグ・GoPro OMNIと同じです。

立体音響収録用のVRマイクやレコーダーも

|

|

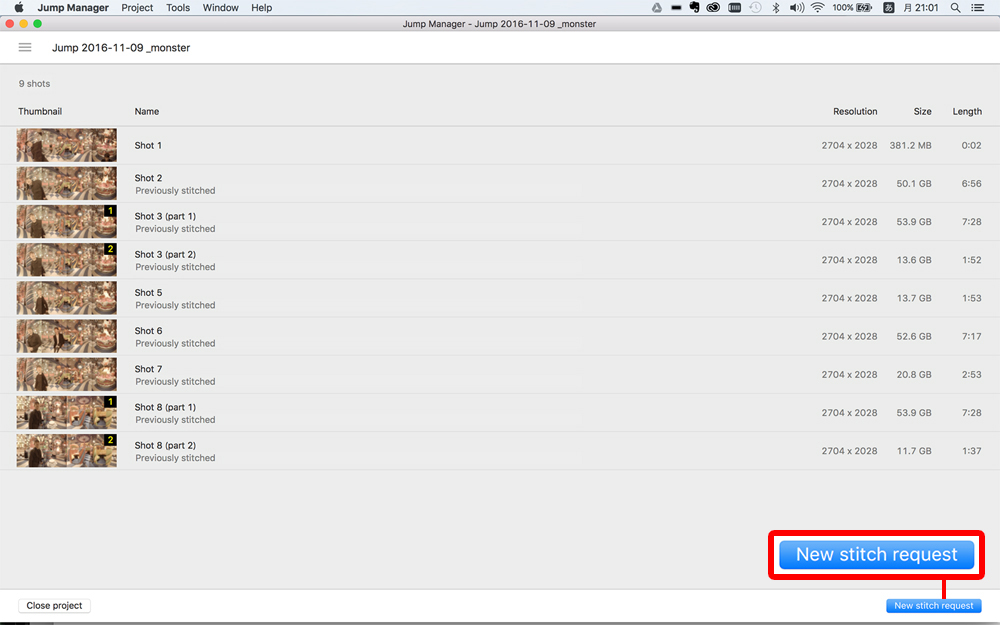

撮影後はGoogleのクラウドAssemblerにアップして、ステッチングは自動で行われます。これにはGoogleが認証したアカウントが必須で、Jump Managerというアプリ(Macのみ対応)を使い、多ポートのUSBハブにmicroSDカードを8枚ずつ2回に分けて、Macにコピー、そこからサーバーにアップするというプロセスとなります。ちなみにコピーするUSBハブは、この時とても熱くなります。

アップするのに数時間かかり、アップ後のステッチングはフッテージの総量やサーバーの混み具合によりますが、3時間~1日以上かかるので、その間は気長に待つことになります。最大8K相当の動画にレンダリングできますが、4Kやさらに小さいサイズを選択することや、スムーズに編集するのに有用なプロキシの生成も可能です。

ステッチングが出来上がると完了を知らせるメールが届き、再びJUMPマネージャーを用いてダウンロードすると「トップアンドボトム方式」の3D360度映像の完成です。JUMPの特徴は任意視点補完のアルゴリズムによる高度な3D効果とスムーズなステッチです。

そして、ダウンロードした素材をPremiereに読み込み、VRとしてプレビューしながら編集をしていくという訳です。サウンドについてはズームH2nなどの空間音声(Spatial Audio)対応のマイクを使用して収録、Premiere上で映像とシンクロさせました。空間音声を実装させるにはQuickTimeとして書き出す必要があり、MacとWindowsマシンでは書き出せるコーデックが違うので少々注意が必要です。

専用クラウドへのアップロードソフトはMacのみの対応

編集環境

編集を終えると書き出し設定で「VRビデオとして処理」にチェックを入れ、「立体視(上/下)」を選択して、レンダリングします。完成した映像は「360度動画であること、3Dであること、立体視であること」を示すメタデータをPremiereと、Spatial Media Metadata Injectorによって付加してから、YouTubeにアップしました。アップ後、3D360度動画として視聴できるまでに数十分かかりますが、スマホのYouTubeアプリ(空間音声はバージョン4.2以降のAndroid端末のYouTubeアプリで聴けます)とカードボードなどのVRゴーグルで空間音声付きの3D360度VR動画として視聴できます。