イベントが終わったらすぐにダイジェスト映像が見たい…。SNS動画が加速するにつれて映像制作者にそういった要望が寄せられるようになった。音楽ライブを専門に手がける藤井大輔さんにご自身が今まさに興味があるというシステムを実際の現場で試していただいた。

テスト検証:藤井大輔

取材・テキスト:編集部 一柳

協力:パナソニック エンターテインメント&コミュニケーション株式会社

制作協力:Ovall (origami PRODUCTIONS)、アドビ株式会社

Ovallの全国5都市を巡るリリースツアーのファイナル、 恵比寿・LIQUIDROOMでのライブを90秒のダイジェストに。今回制作した動画はこちらから視聴可能。

【Frame.io Camera to Cloudに対応したLUMIX】

GH7だけでなくS5II、S5IIXでも可能に。複数台を同時に使用できる

現時点でFrame.io Camera to Cloudに対応しているLUMIX。GH7に続きファームアップによりSシリーズのS5II、S5IIXも対応。今回はGH7で試すことにした。

【 Frame.io Camera to Cloudとは?】

Creative Cloudプラン契約で5つのプロジェクト、100GBのクラウドストレージまで利用できる

Frame.ioとはアドビが提供するクラウドベースで撮影素材の共有、管理やレビューを一元管理できるツール。クラウドにカメラで撮影した素材を順次アップしていき、データ共有するだけでなく、Premiere Proなどで編集できるのがCamera to Cloud機能。Creative Cloud を利用しているユーザーなら、アドビ資格情報で新規登録すると、100 GB の専用 Frame.io クラウドストレージ、別のユーザーと最大 5つの異なるプロジェクトで作業でき、さらに Camera to Cloud を含む拡張無料プランを利用できる。アップグレードプランも用意されている。詳しくはこちらから。https://frame.io/pricing

Frame.ioは現在V4が利用できるようになっているが、Premiere Proとはまだ連携していないので、今回はV3を利用した。

一眼での制作とスピードを両立できる仕組みはないか?

フェス会場から大ホール、ライブハウスまで、音楽ジャンルを問わず、様々な会場でチームを組んで日々ライブ撮影をしているビデオグラファーの藤井大輔さん。

「最近は、短いものでいいから、その日のうちにダイジェスト映像を作ってくれないかと言われます」

SNS動画が加速した結果、ライブに参加した人が、帰りにアップされているダイジェストを見るといった用途だけでなく、全国何カ所かのツアーではそういったダイジェスト映像があることで、その後の集客に繋がってくるためだという。

ライブ撮影は各人が持ち寄ったデジタル一眼のシステムでマルチカメラで収録して、その場でスイッチャーを入れてスイッチングすることもあれば、それを元に個別のカメラで収録したものを編集するが、当日アップとなると、そのシステムとは分けてスマホでメイキング的な素材を撮ってまとめるしか方法がなく、それが悩みの種だったという。

そんなときに知ったのがFrame.io Camera to Cloudだった。撮影しながら、同時に素材をクラウドにアップして編集も進められるのであれば、一眼を使うマルチカメラでのライブ撮影・編集とスピードを両立できるのではないか? 今回、実際のライブ会場で当日のアップが可能なのか試すことになった。

ライブ中にダイジェスト編集を進めるには

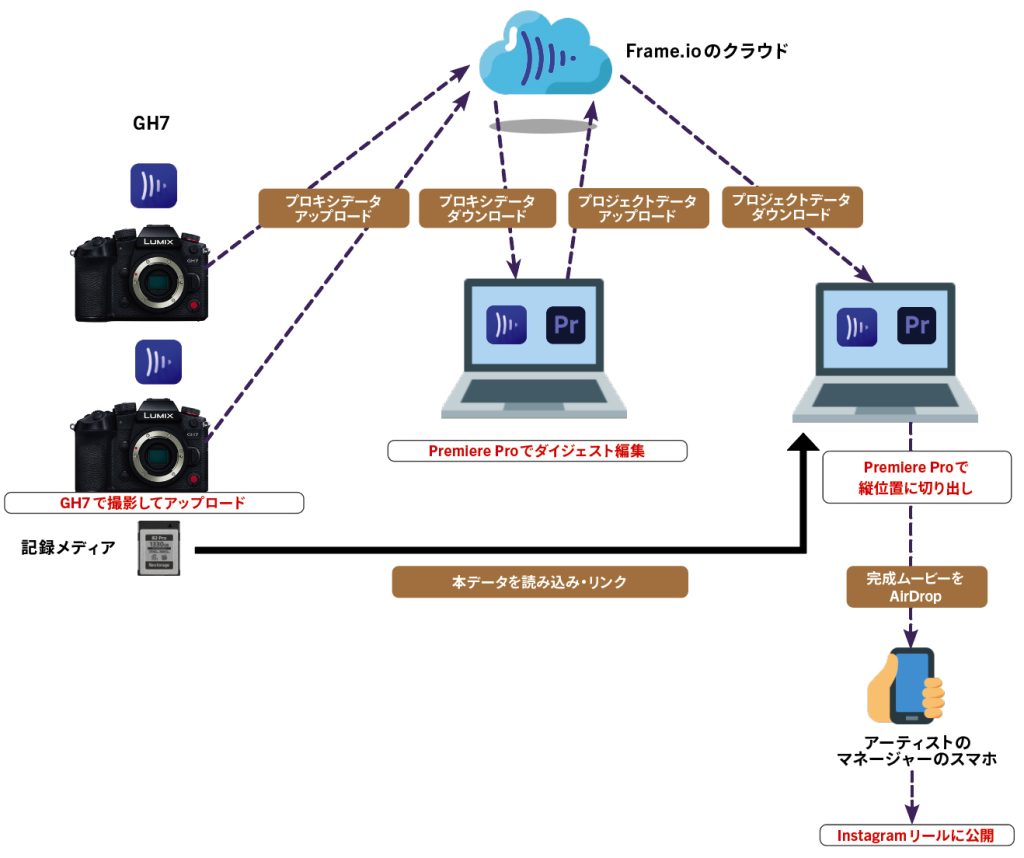

当日中に90秒のダイジェスト映像を仕上げるためのワークフロー計画

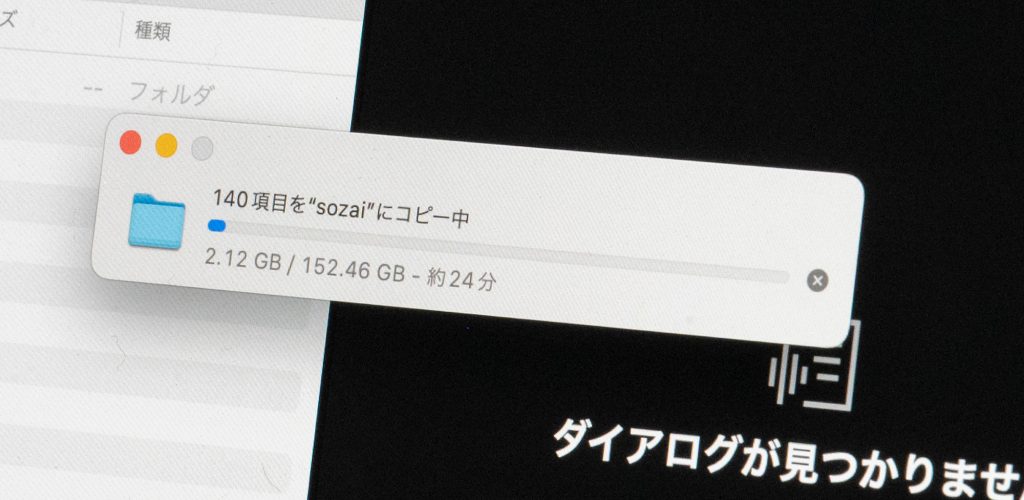

クラウドにアップするのは比較的軽いプロキシデータになるが、Wi-Fiや携帯回線を使った場合、回線の状態が問題になる。事前に他のライブ会場や、現地で検証した。恵比寿・LIQUIDROOMでは、GH7からのアップロードは会場のスタッフ用のWi-Fiを使用したが、アップロードに30Mbps程度で決して高速とは言えない状況だった。

当日はそのせいか、やや長回しをした大きめのファイルはアップロードが後回しになる傾向があったが、時間がかかってもアップロードは可能だった。エディター側の環境は携帯回線を利用したが、こちらはアップロード30Mbps、ダウンロード10Mbpsという速度だった。

プロキシをクラウドで共有してライブ中に編集を進める

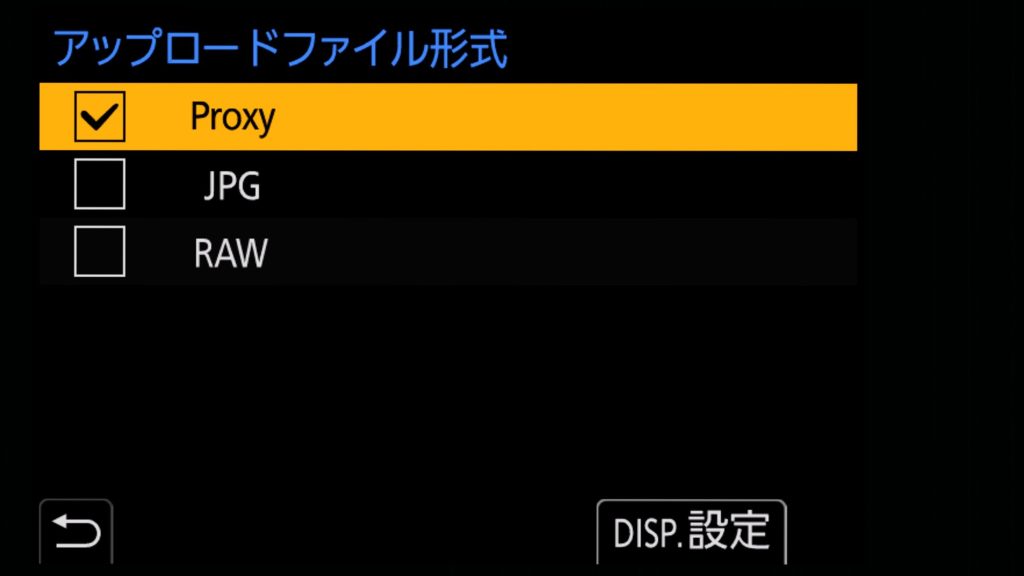

今回のシステムは上図のような流れで制作する。GH7を2台用意し、カメラマンふたりがステージ前方と後方で撮影。映像を見ていただければ分かるように、最低でも前と後ろのカメラがあれば編集して魅力的な映像にできる。それぞれの収録は4K。軽いデータであるプロキシをもう一枚のカードに収録しながら、Frame.io Camera to Cloudを利用してデータをアップロードする。音声もカメラマイクで同時収録したものを使用する。

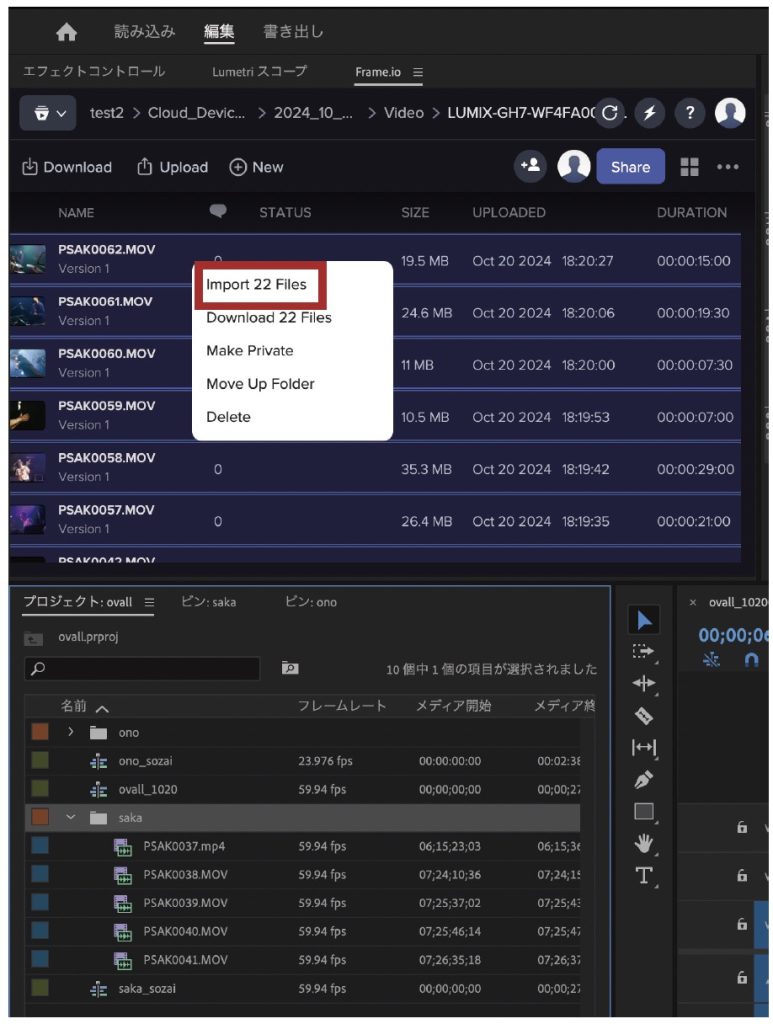

別の場所にいるエディター(今回は藤井さんが担当)は、Frame.ioに次々アップロードされていくプロキシデータを受け取り、ビンに登録し、ライブ中に編集していく。最終的にはひとつの曲をベースにして、そこにインサートしていくかたちで90秒ほどのダイジェストにする(厳密にはその曲ではないシーンもインサートすることになる)。

カメラマンは、事前に決められたダイジェストに使いたいシーンの曲では、フレーズを切らずに長めに収録しておく。

ダイジェスト編集が終わったら、そのプロジェクトファイルを保存し、会場にいるカメラマンに送る。ここでカメラマンとエディターでFrame.ioのクラウド経由でプロジェクトデータをやりとりすることも可能だ。

カメラマンは自分のPCでPremiere Proを開き、そのプロジェクトを読み込む。自分の手元にある撮影の本データを読み込んで再リンク。最終的にはSNS用の縦位置のムービーを作りたいが、撮影は横位置、編集したプロジェクトも16:9の横位置になっているので、カメラマン側で左右を切って縦位置のムービーとして書き出す。オリジナルは4Kなので、縦1080画素のムービーに仕上げられる。そのムービーをライブ終了後、現地でAirDropなどで渡して終了となる。

Frame.io Camera to Cloudのための設定

Frame.ioのプロジェクト設定

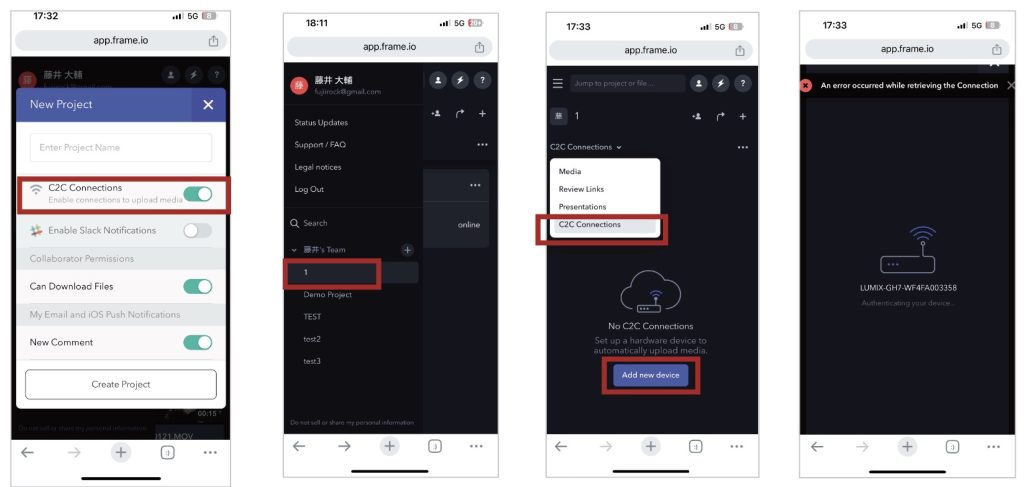

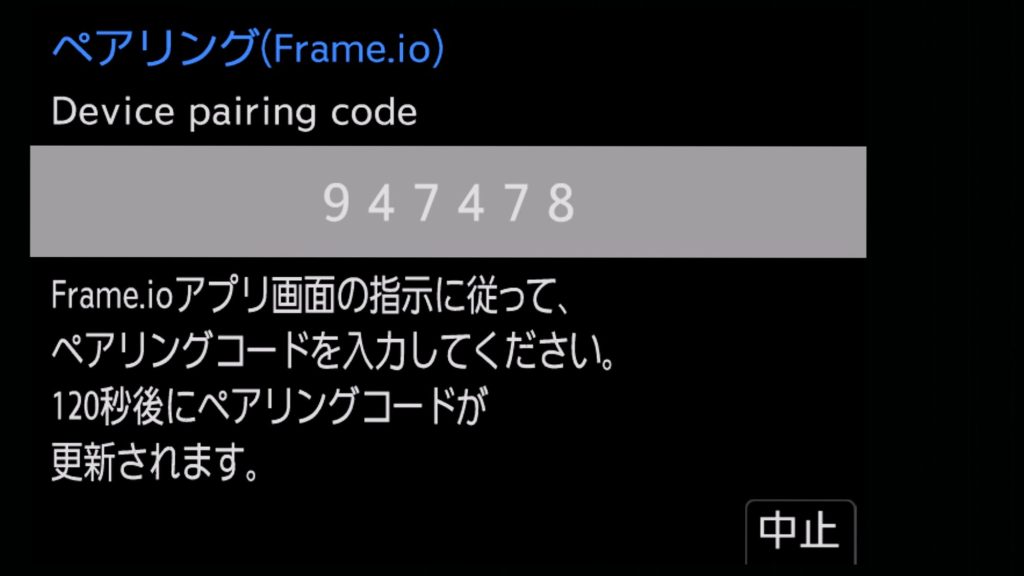

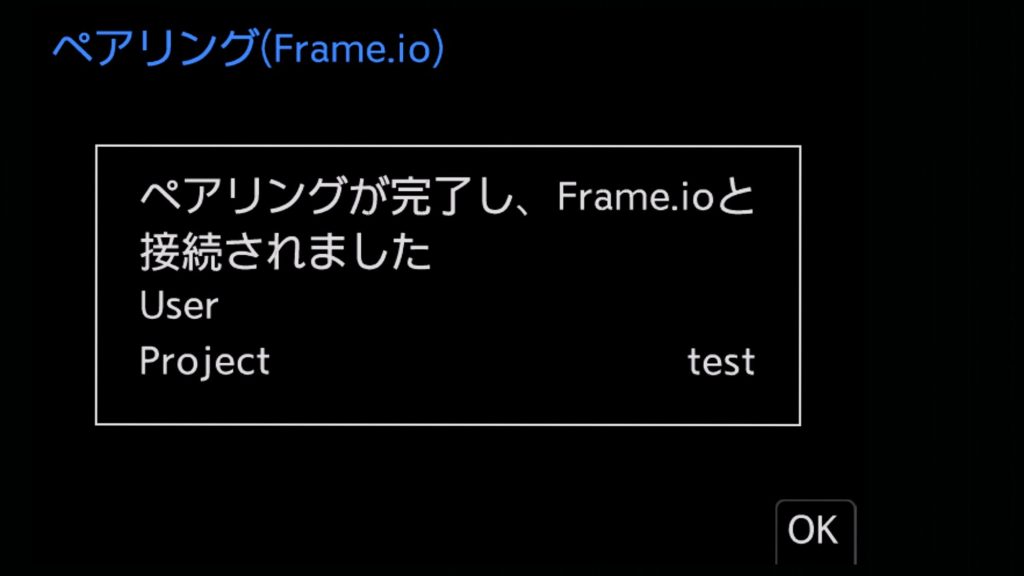

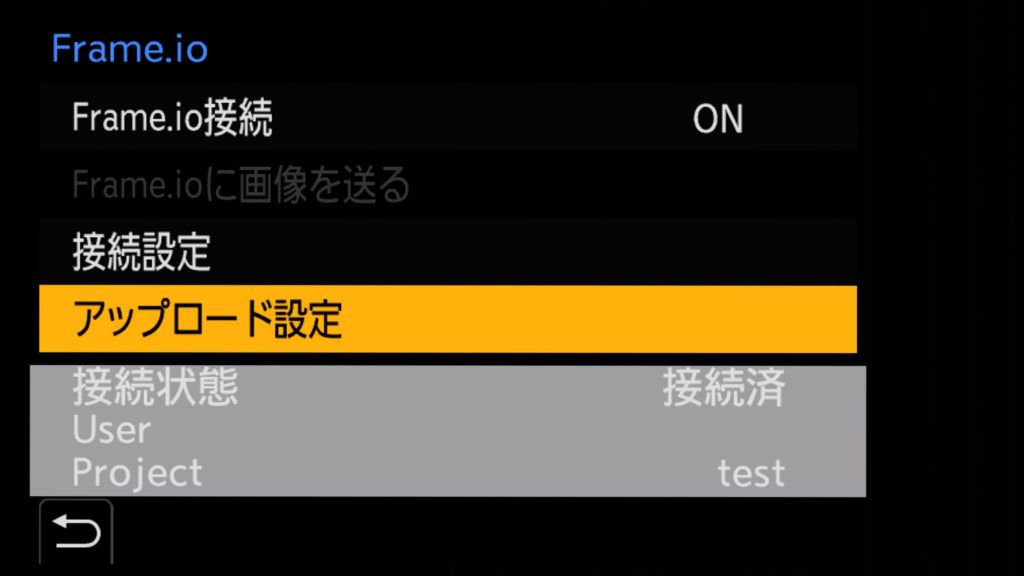

Frame.ioのアプリを入れてプロジェクト設定を行う。アプリはPCでもスマホでも設定が可能。プロジェクト名をつけて、C2C(Camera to Cloud) ConnectionsをONにする。使用するカメラを新しいデバイスとして登録していく。

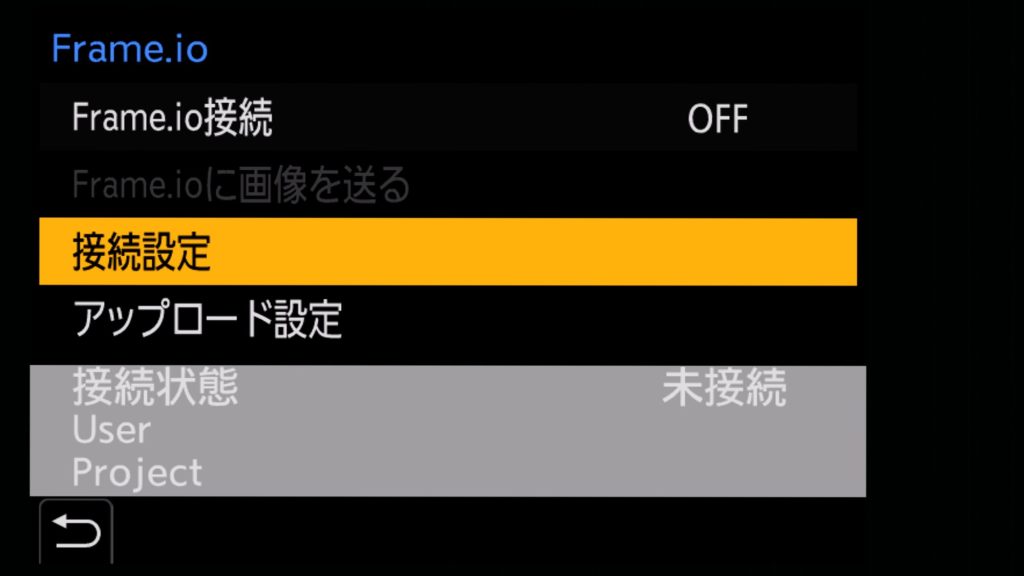

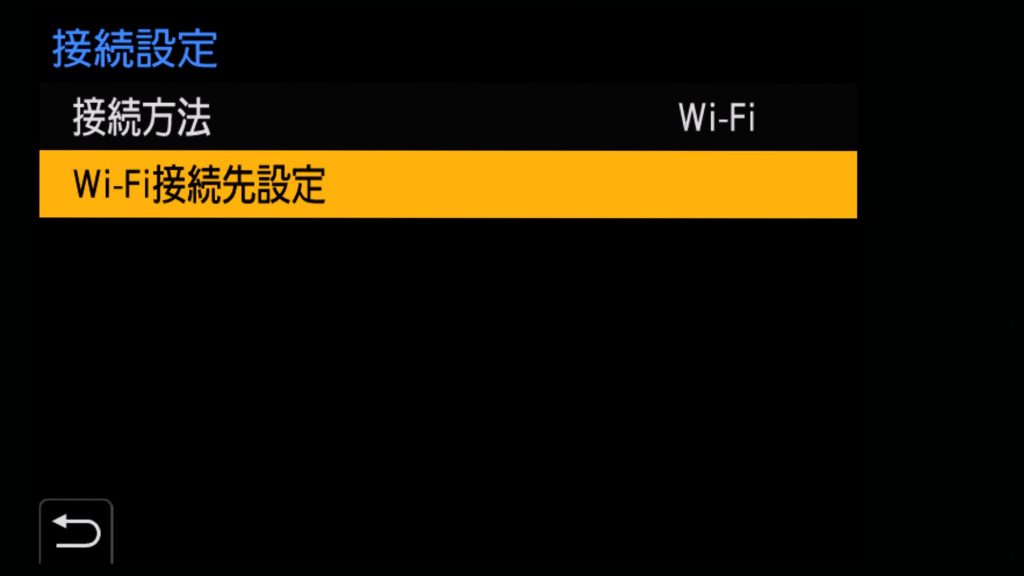

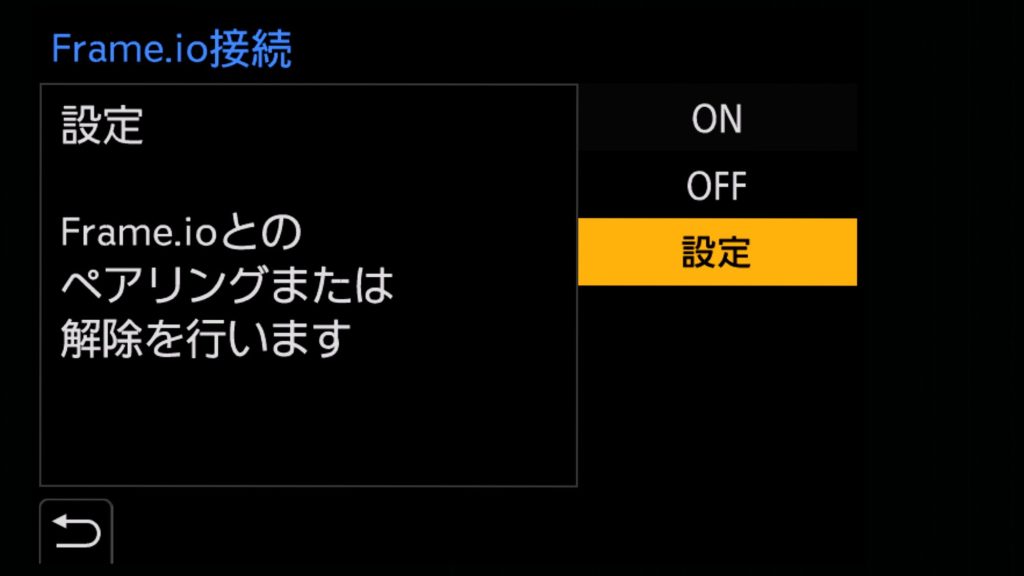

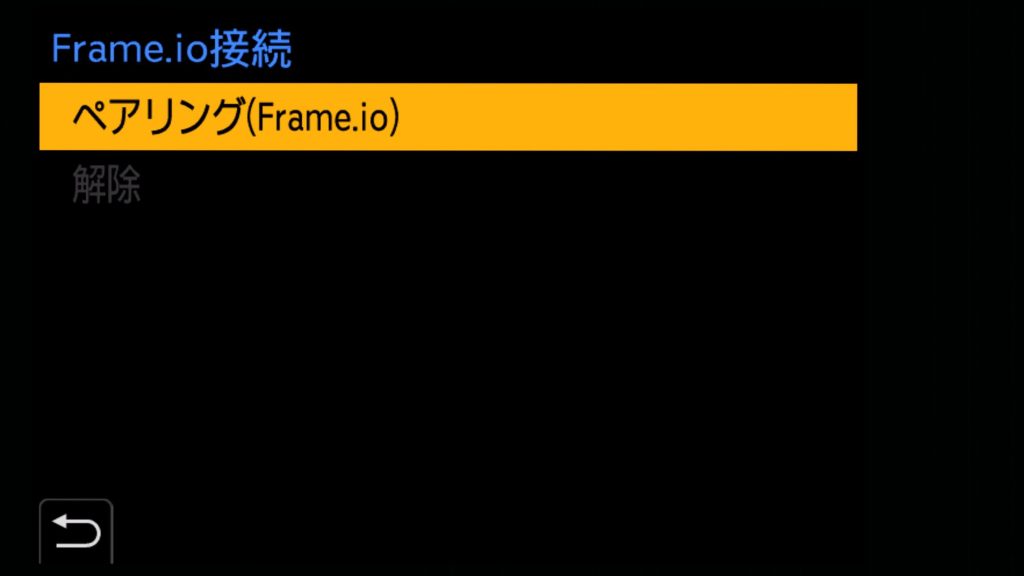

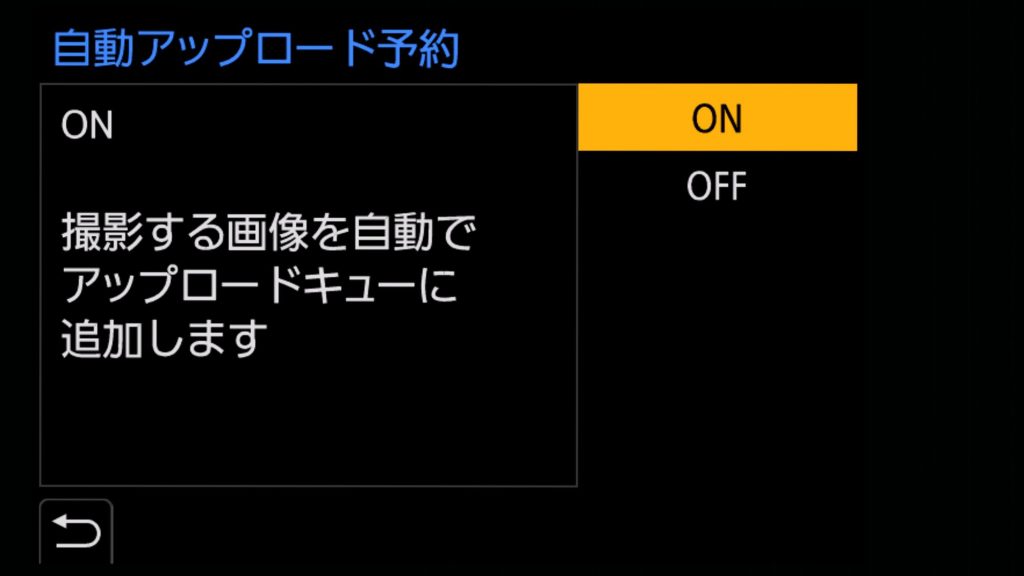

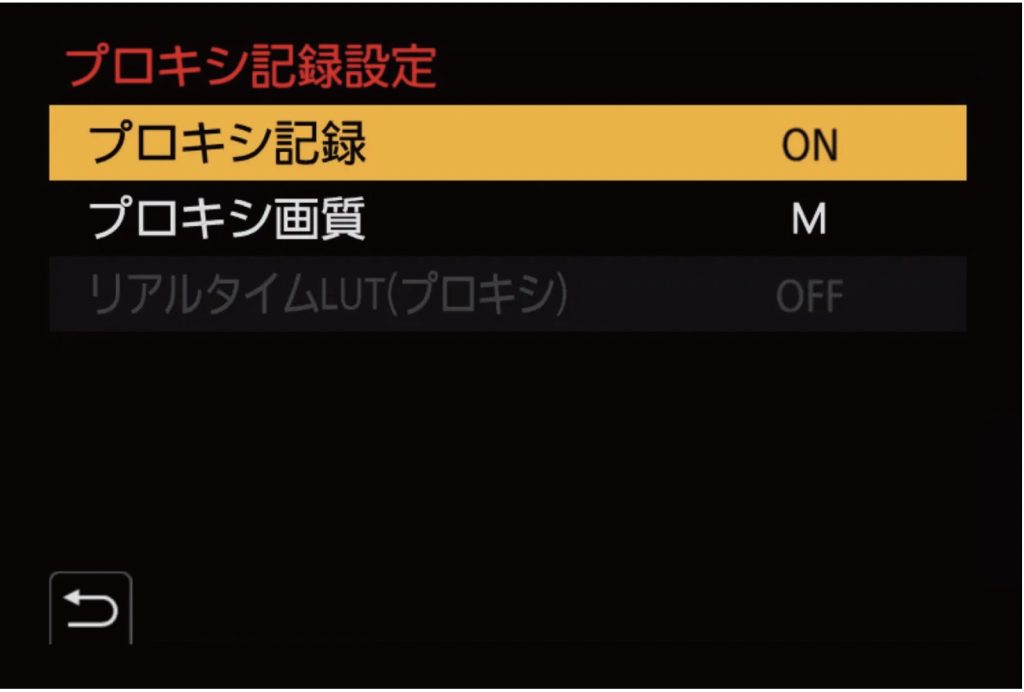

GH7の設定

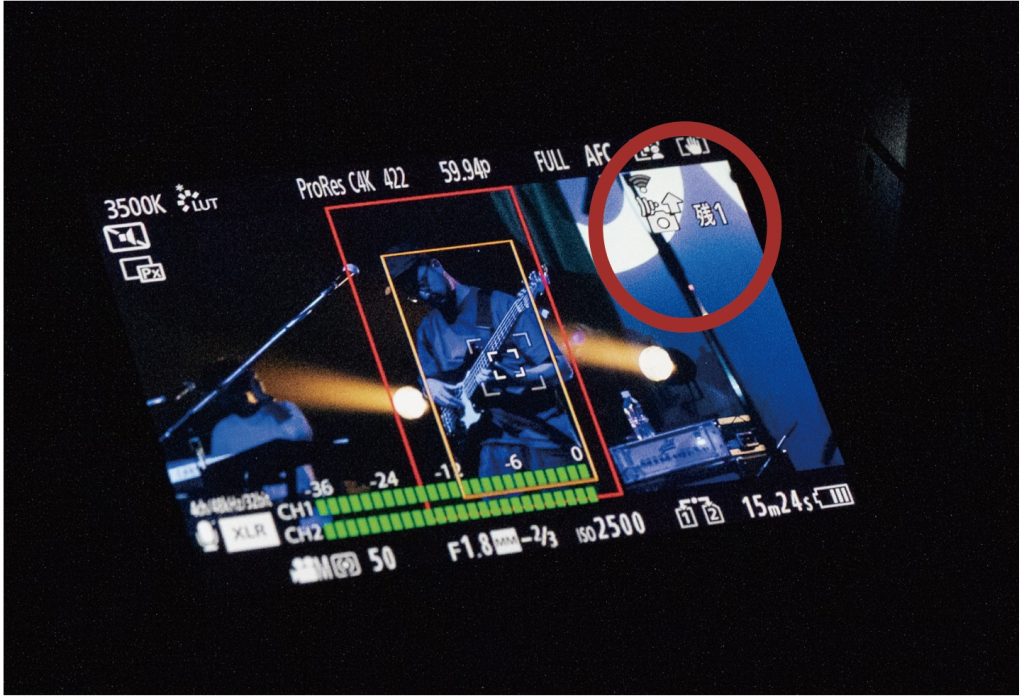

ちなみに、5.6K記録では同時にプロキシ記録に対応していないので、4K解像度以下の同時プロキシ記録に対応している撮影モードを選ぶ(下)。

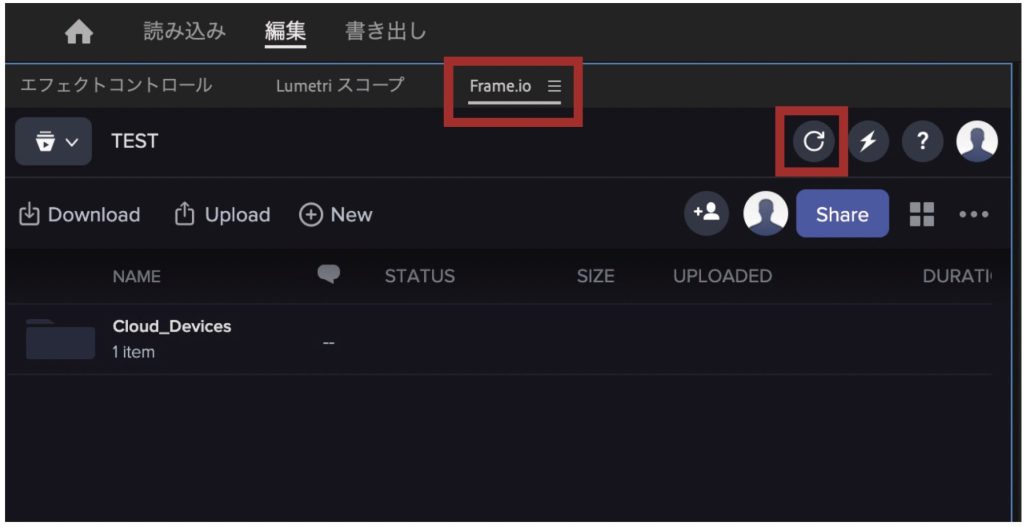

アドビPremiere ProでのFrame.ioの操作

ちなみにFrame.ioの部分はローカライズされておらず英語表記。またクラウドにある段階では、2台のGH7のデータはカメラごとにフォルダに分かれている。

実際のライブで実践してみる!

ライブ会場で2台のGH7で撮影しながらプロキシファイルをクラウドにアップロード

2台のカメラは前方と後方ともに手持ち。レンズは前方がLEICA DG VARIO-SUMMILUX 25-50mm/ F1.7 ASPH.、後方がLEICA DG VARIO-ELMARIT 35-100mm / F2.8 / POWER O.I.S.。フォーカスはAFにした。LUMIXの特徴である 「リアルタイムLUT」機能で藤井さんが作ったLUTを当て、かつ最終的に使われる縦位置のフレームも表示しながらフレーミングしている。

会場前方のカメラ

会場後方のカメラ

収録中

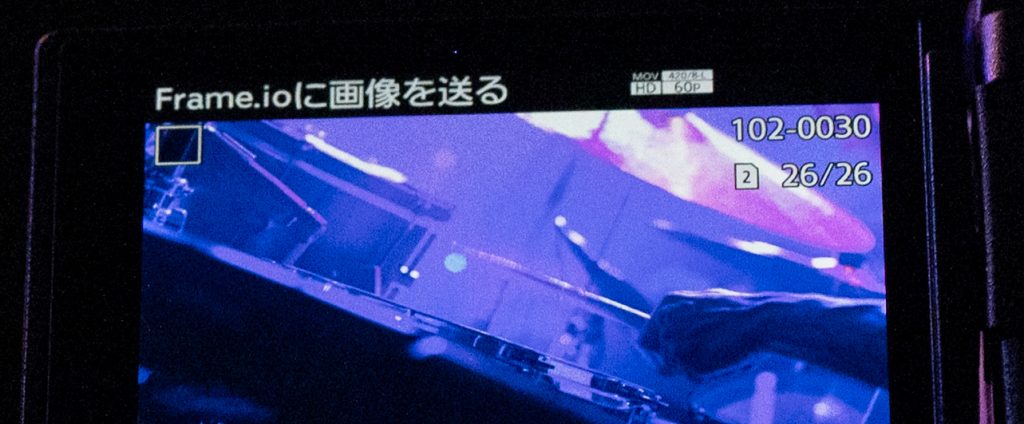

収録がストップしてアップロード中

撮影したファイルはもれなくアップされているか確認

カメラマンとLINEでやりとり

手動でFrame.ioの画像を送る

遠隔地にいるエディターが90秒のダイジェストムービーを編集

ライブ会場のカメラマンが縦位置ムービーを書き出し

横位置のプロジェクトで仕上げる

↓

縦位置に書き出す

↓

SNSに公開

いちいちメディアを抜き差ししないワークフロー革命

ライブが始まったのが18時で終了が20時過ぎ。ライブ中から編集作業をはじめ、ライブが終わったときには編集はほぼ終わり、書き出してカメラマンにプロジェクトを渡すところまでできていた。しかし、カメラマンのほうでメディアからファイルを読み込むのに時間がかかった。もし低解像度でも良いのなら、プロキシをそのまま書き出せばライブが終わった瞬間にムービーができていることになる。

ただ、今回のように本ファイルをリンクさせて書き出した場合でも、21時半にはOvallのマネージャーにムービーファイルをAirDropで共有し、その夜遅くにはOvallのInstagramにアップされていたので、今回のワークフローは大成功だと言えるだろう。

藤井さんは、このファイル共有のスピードは画期的だと言う。いちいちメディアを抜き差しして手渡していた手間が省けるので、今回のようなダイジェスト編集だけでなく、チーム制作の現場でいろいろと便利になりそうだと期待する。

Frame.io Camera to Cloudのような機能は、ビデオグラファーの仕事のやり方を変えていくことになるだろう。