複数の視点の画像から視点を自由に動かせる3D空間を構築するNeRFや3DGS(3D Gaussian Splatting)が新たな映像制作の手法として注目されている。この“自由視点映像”によって映像制作はどのように進化していくのか? CGテクニカルディレクター、ドローンオペレーターとして活動してきた北川哲一郎さんが実際に手がけた作品中のNeRFや3DGS使用例を解説しながら、フォトグラメトリ・NeRF・3DGSの違い、ワークフローなども紹介する。

※この記事は有料会員限定のコンテンツです。続きを読む場合はVIDEO SALONプレミアムコンテンツへの会員登録が必要になります。この記事の最下部にあるボタン「続きを読む」をクリックして会員登録をお願いいたします。1記事・250円。またはサブスクプランならば月額1,000円(2024年1月号より月に4-5本を配信)にて全記事を閲覧できます(既にウェビナープランや電子版プラン、ウェビナー+電子版プランにご加入の方は新規の登録は不要です)。

講師 北川哲一郎 Tetsuichiro Kitagawa

TVCMやゲーム内動画制作を行い、『KINGSGLAIVE FINAL FANTASY XV』の技術監督を最後にSQUARE ENIXを独立。並行して趣味でドローン自作から開始。DJI Phantom 2から購入し、空撮を楽しむ中でドローンレースやFPVにハマり、独立して自作FPVドローンでの空撮を得意とする。2018年3月にはgrid_FPV合同会社を設立。現在、広告・MV・ライブ空撮の比率が多めとなっている。また、2022年6月からNeRFや生成AIを用いて静止画や動画制作し、現在3DGSも用いて業務を行なっている。

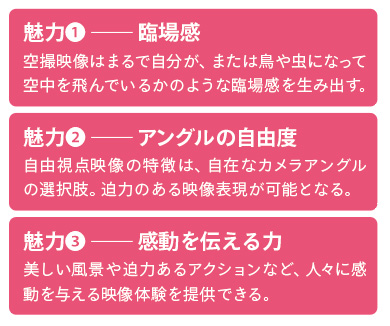

ドローンによって得られる自由な視点でこれまで撮れなかったアングルや動きを実現

grid_FPV 合同会社の代表・北川哲一郎です。今回は「自由視点映像NeRF / 3DGSの作り方」というテーマでお話しさせていただきます。まずは、空撮のドローン屋さんがなぜNeRFや3DGSをやっているのか解説します。

もともとSQUARE ENIXで『FINAL FANTASY』関連のフルCG映像制作をしていたんですが、趣味でドローンを始めたんです。自動航行ドローンを自作してGoPro HERO3を貼り付けて空撮してみたんですが、ブレブレの映像しか撮れず失敗したり、DJI Phantom 2を買って空撮したり、ドローンレースに出場したりという感じでした。

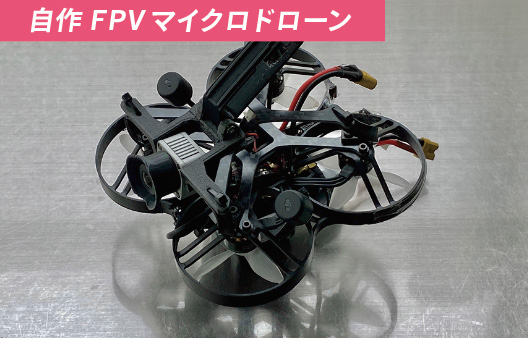

SQUARE ENIX退社後にドローン空撮の会社を立ち上げようと思い、2018年3月にgrid_FPV 合同会社を創業しました。FPVというのは一人称視点で、ドローンのカメラ映像のみで飛行させる撮影が得意な会社としてスタートし、自作のマイクロドローン、レーシングドローンやシネマカメラなどが搭載可能なFPVシネリフターの機体開発、特殊空撮、VR開発や生成AIを用いた案件などの実績があります。

基本的には“空間を生かした映像制作”に挑戦していまして、さまざまな視点から見た映像を提供し、お客さまのニーズに合わせた撮影を心がけています。これまでに広告、映画、MV、ライブ、イベントなど、さまざまな分野でドローンを活用した撮影を行なってきました。

弊社の飛行可能なドローンには、DJIのような安定した映像が撮れるドローンと自作のドローンがあります。自作ドローンはFPVのレース機やフリースタイル機と呼ばれるものです。全力でプロペラ回すと1秒後には時速150kmぐらいになるパワーがあるので、回転したり、急加速・急停止したり、高速で飛行させたりできる特殊な動きが可能です。ほかにも自作機には手のひらサイズのマイクロドローンがあったり、スタビライザー込みのカメラが乗るシネリフターがあったり、360度カメラやiPhoneを乗せるための専用機があったり…既存のパーツや3Dプリンターも使いながら、いろんなドローンを用途に合わせて開発していますね。

たとえば『JAPANESE SEAFOOD』という日本食品の海外プロモーション映像では空撮をたくさん使っていただいて、安定型ドローン、マイクロドローン、レースドローンの3機種をひとつの作品の中で使い分けています。レースドローンでスピード感を演出しつつ、マイクロドローンでは狭い場所にも飛び込み、俯瞰的なショットは安定型ドローンで撮影しました。案件によっては、そのとき専用のドローン開発をする場合もあります。キャストの近くを飛ぶ可能性がある場合にクッション性のあるプロペラガードを3Dプリントしてできるだけ軽量で空気抵抗少なく取り付けたり、細かい開発〜カスタムはやってますね。

最近の少し変わった撮影としては、横浜で開催されたドローンショーの様子をドローンで至近距離から空撮した『コカ・コーラ クリスマスドローンショー』や、VR空間内で初めてライブ空撮を行なった『HATSUNE MIKU EXPO 2023』などがあります。自己紹介っぽくなりましたが、空撮をメインに自作ドローンによる自由な視点、既存の地上カメラでは撮れなかったアングルや動きで撮影してきたということが、今回のNeRF / 3DGSの取り組みにつながっていきます。

ドローンを用いた自由視点映像の魅力

北川さんが飛行させるドローンの種類

北川さんがこれまでにドローンで撮影してきた作品

● 自由視点として特に新規性があった作品

自作FPVマイクロドローン黎明期のPV。

日本初のFPVレーシングドローンを用いたTVCM。

Japan Expo Asiaで新年の打ち上げ花火内を空撮。

日本初の都心でのビルダイブ映像などのMV。

● 最近の広告用空撮とMV用空撮

星野リゾート初のTVCM。

ソニーのVlogCam ZV-1 IIグローバル紹介動画。

5分ノーカット空撮に挑戦。

FX3搭載シネリフターで屋内空撮。

●有観客/無観客のライブ空撮

「ワンピース」UTAのライブでの撮影。

撮影におけるドローンの“持ち場”とドローンならではの魅力

現実世界を自由視点で撮影する手法としていま注目されているNeRF / 3DGS

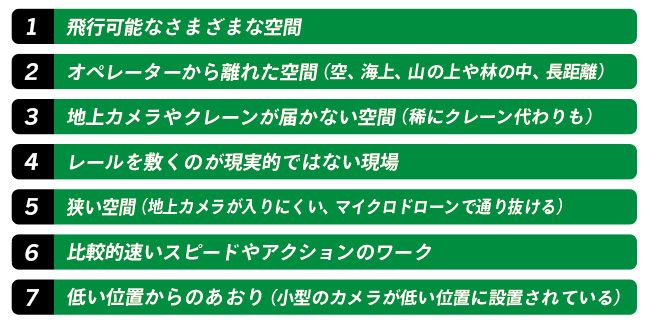

一度ドローンの持ち場を整理しておきます。ドローンは飛行可能なさまざまな空間から撮れるので、人間がそもそも行けない空、海上、山の上などの離れた場所、地上カメラやクレーンが届かない範囲が持ち場だと思います。あとはレールを敷いて安定的に撮る場合でも、ものすごく長いレールを敷くのは予算がかかりますし、空中にはレールが敷けないので、ここもドローンの持ち場になります。マイクロドローンでしか通り抜けられない狭い空間や、レースドローンでしか撮れないようなスピード感のある画や面白いカメラワークも同様です。

では、ドローン以外で現実世界を自由視点で撮影するにはどうしたらいいのか。オムニコプターのように機体全体が回転し移動可能なものであれば既存のドローンよりももっと自由なアングルで撮影することができます。ただ、現実的な導入には至っていないので、これからの技術開発に期待しています。あとは、3DCGで現実そっくりな世界を制作してカメラワークをつける方法。いまの技術でも実現できますが、クオリティの高い世界を作ろうとするとコストがかなり高くなってしまうのが難点です。では、現実世界をキャプチャーしてソフトウェア内でカメラワークをつけるのはどうか…それが今回のNeRFや3DGSの役割になってきます。

NeRF / 3DGSの基礎知識

フォトグラメトリ(写真測量法)・NeRF(Neural Radiance Fields)・3DGS (3D Gaussian Splatting)の違い

フォトグラメトリ、NeRF、3DGSはどれも空間や物体をさまざまな方向から撮影し、その複数の写真をもとに3次元の空間や物体を再現する技術で、その出力データを利用し3Dソフト、アプリ(Unity、Unreal Engineなど)のソフトウェア内部でカメラ位置を変化させて活用。先ずSfM(Structure from Motion)を用いて、移動したカメラから得られた画像をもとに3次元上のカメラ位置やアングル、3次元の点群を得た上で生成のために計算する。

生成:3Dポリゴンとテクスチャを生成保存。

特徴①:既存の3Dデータの扱いが可能。

特徴②:反射、屈折、透過や空などの輪郭のないシーン、遠景の細かいディテールなどを表現できない。

詳細:被写体をさまざまなアングルから撮影し、そのデジタル画像を解析、統合して立体的な3DCGモデルを作成する手法。いままでの3DCGの素材のひとつとしても使用できる、ポリゴンとテクスチャや物体表面のノーマル方向などを得ることができる。しかし、透明な物や反射する物に対応できないため、撮影の制限は大きい。

例:https://sketchfab.com/3d-models/realityscan-test-fpv-drone-374a0729e21f4c4f9663171a86fe0227

生成:放射輝度と透明度をもつボリュームを生成保存。

特徴①:反射、屈折、透過の表現が可能。

特徴②:学習とレンダリングに時間が必要。

詳細:ニューラルネットワークを使用して、複数の写真から3Dシーンを生成する技術・NeRFの入力は5次元(空間座標のx、y、zとカメラ視線方向のθ、φ)で、この5次元ベクトルを入力とし、密度と色の4次元を出力する深層学習の一種。Multi Layer Perceptronを学習するのがNeRFの基本コンセプト。出力は密度(≒不透明度)と放射輝度(≒RGBカラー)。ある座標の色が知りたい場合、座標(とカメラ方向)を入力すると、NeRF学習後のニューラルネットワークのモデルパラメーターの中から色(と密度)が返ってくるため、これを利用してニューラルレンダリング(ボリュームレンダリング)で新しい視点位置からの新しい画像を生成。

例:https://mobilenerf-viewer-launch.pages.dev/

生成:パラメータを持つ3Dガウス関数分布を生成保存。

特徴①:反射、屈折、透過の表現が可能。

特徴②:NeRFよりも短時間で学習とレンダリングが可能で高精細。

詳細:SfM結果のカメラパラメーターと3次元点群を得る。3次元の点群から3Dガウス関数を位置、共分散行列、不透明度で定義3Dガウス分布を画像に合わせてニューラルネットワークで最適化。レンダリング時はニューラルネットワークを使わず、カメラからのピクセルを16×16のタイルに分割してラスタライズを並列処理。アルファブレンディングを利用したレンダリングを行う。

【長所】高品質でフォトリアルなシーン。高速・リアルタイムのラスタライゼーション。比較的早くトレーニングできる。

【短所】VRAMの使用量は多め。既存のレンダリングパイプラインと互換性がない。静的(現在のところ)。

例:https://huggingface.co/spaces/dylanebert/igf

フォトグラメトリにはできなかったディテールの表現が可能になる

フォトグラメトリも含めてNeRFと3DGSの基礎をお話しすると、どれも空間や物体をさまざまな方向から撮影し、3次元に再現して再撮影することができる技術です。詳しくは上の表を参照していただければと思いますが、生成保存されるものがそれぞれで異なります。

フォトグラメトリは3Dのポリゴンにテクスチャを貼ったものが生成されますが、反射・屈折・透過や、空のようなディテールのないものは計算で割り出せないので、ポリゴンが壊れたり、ヘンな形になってしまうこともあります。

NeRFは放射輝度という光の強度や色と透明度がボリュームとして生成保存されます。反射・屈折・透過の表現は可能ですが、こちらもディテールがなさすぎると計算で割り出せずエラーが出ることがあります。また、学習とレンダリングに結構な時間がかかってしまうのがデメリットと言えるかもしれません。

3DGSはこの中では最近のトピックですが、パラメータを持つ3Dガウス関数分布が生成されます。言葉にすると理解が難しいですが、3DGSも反射・屈折・透過の表現が可能で、NeRFよりも短時間で学習、レンダリングできる、しかも高精細という特徴がある…と、まずは覚えていただけると良いと思います。