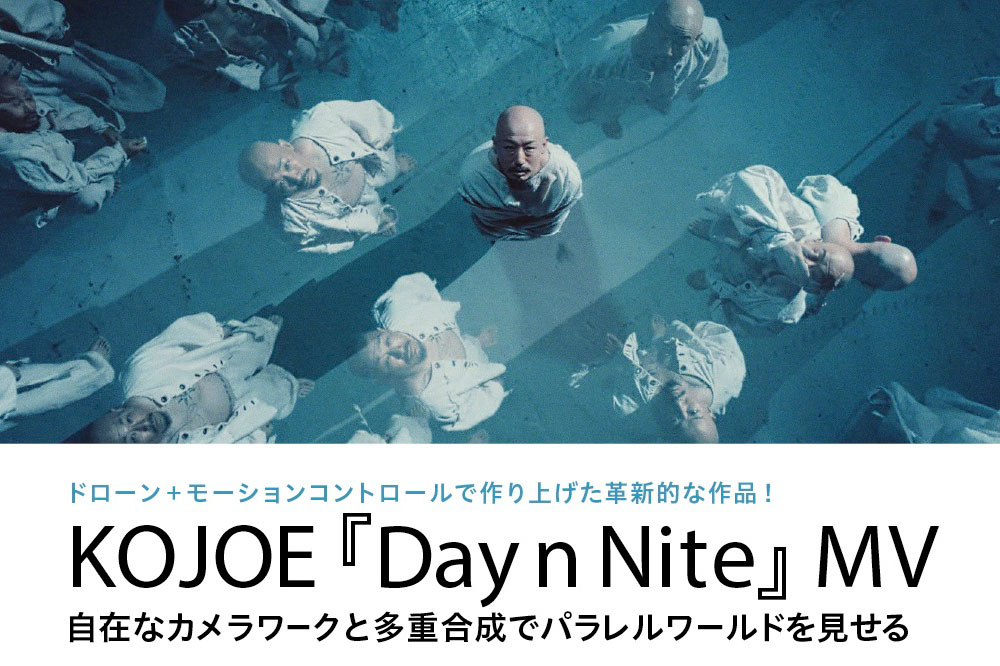

昨年11月に公開されたヒップホップアーティスト・KOJOEとTOKYOのオリジナルショートムービー。プログラミングによるドローンのモーションコントロールで、狭い空間を自由に飛び回り、同じ軌道を飛ばすことで多重合成を実現した。世界でも初となる手法に空撮関係者の間でも話題を集めた作品の制作の裏側についてお話を伺った。

文●青山祐介/構成●編集部

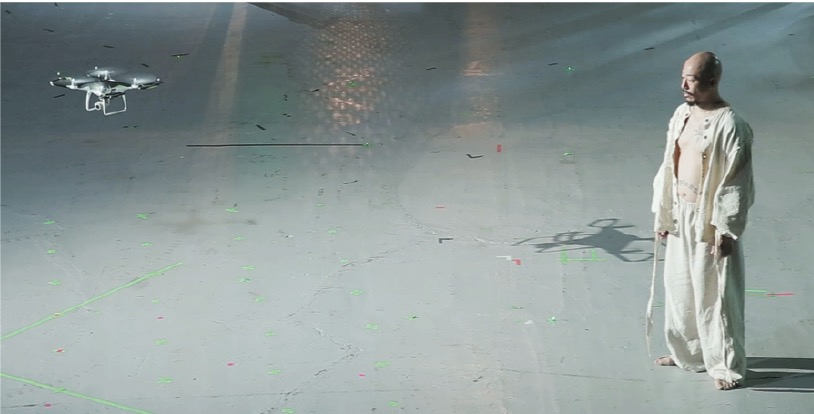

KOJOE『Day n Nite』ミュージックビデオ

漂う視点を表現したドローン

「自分の人生の選択肢に直面していた時期に、KOJOEの『Day n Nite』を聞いてシンクロする部分を感じ、一緒にMVを作ってみたいと思ったんです」。こう話すTOKYOの北田監督。人生の中で選択肢の先にあるかもしれない別の人生、無限にあるパラレルワールドを表現したこの作品。空中を漂いながら垣間見る視点をドローンが担い、そこから主人公の人生のパラレルワールドを描いている。この“漂う視点”から見たパラレルワールドを表現するのに、ドローンが最適だと考えた北田さん。プロデューサーの上野さんとともに白羽の矢を立てたのが、新しいメディア表現技術の開発に取り組んでいるFIGLABの横山さんと杉山さんだった。

「最初に取り組んだのは、ドローンをプログラム制御することで何ができるか、ということ。そこでまずはParrotのドローンを使って、『前へ進む』『横に進む』といった簡単なプログラムを作って飛行させることから始めました」と横山さん。

その結果、ある程度同じ軌跡で飛ぶことは分かったが、単純な動きしかできないことと、なにより軌道の精度が高くない。そこで横山さんは、次のステップとして座標でドローンの位置を管理する方法の検討を始める。

▲MVを手がけたのは太陽企画のクリエイティブチームTOKYO。写真左から北田一真監督(TOKYO)、ドローンのプログラミングを手がけたのはアマナデザイン・FIGLABの横山徹氏と杉山 諒氏。プロデューサーの上野雄大氏(TOKYO)。

実験ではVIVEも試した

一般的にGPSによる位置制御機能を持ったドローンは、屋外であれば衛星からの電波を受けて自動的に位置を修正したり、自動航行をすることができる。しかし今回の作品は中二階のある倉庫内での撮影。衛星からの電波が入らない室内ではこの機能が使えない。そこで横山さんはHTCのVIVEトラッカーをドローンに積んで、その位置を把握することを試みた。しかし、VIVEがドローンの振動に弱く、それが原因でまったく違う場所にいる、といったような誤情報を出力してしまった。そして、最終的に使うこととなったのがモーションキャプチャーカメラの技術だ。OptiTrackのモーションキャプチャーカメラを倉庫内に死角が生まれないように30台設置し、マーカーをドローンに装着。飛行するドローンの位置を独自に開発したプログラムに取り込み、リアルタイムで予め決めたルートと比較し、修正の指示をドローンに伝えた。それにより正確にドローンの位置を制御しながら、あらかじめ決めたルートの通りに飛行させることができるようになった。

撮影スタジオに30台のモーションキャプチャーカメラを設置して、ドローンの動きをスキャン

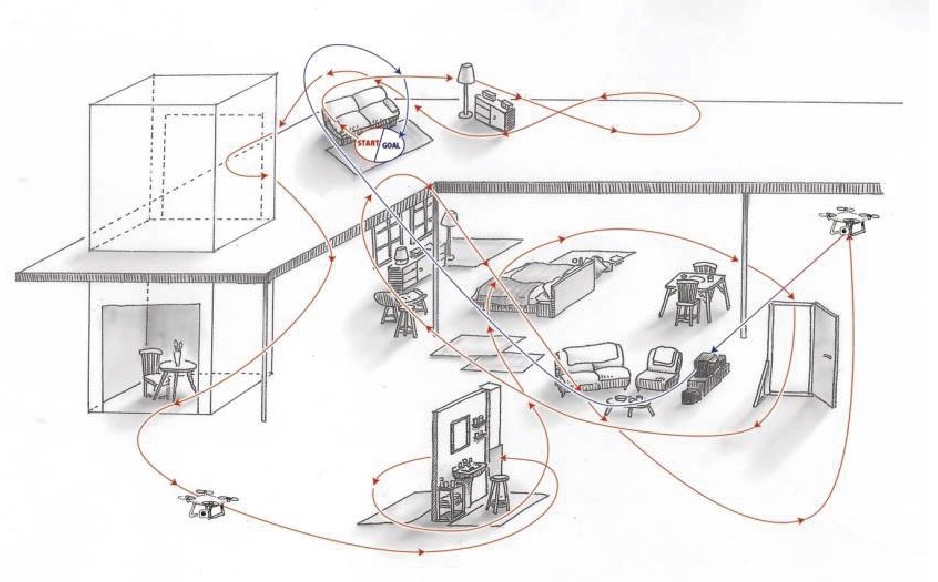

◉撮影現場と飛行プラン

▲撮影スタジオは1階と2階が吹き抜けになった倉庫。各所にセットを配置してモーションコントロールでドローンを同じ軌道で飛行させた。撮影した複数のショットを多重合成することで、パラレルワールドを表現した。

◉撮影に使用したのはDJI Phantom 4 Pro

▲Mavic 2やInspire2などのドローンでもテストを行なったが、画質や機動性の面を考慮してPhantom 4 Proを採用。ドローンにはテープでモーションキャプチャー用のカメラで読み込むためのマーカーが複数取り付けられている。

▲Mavic 2やInspire2などのドローンでもテストを行なったが、画質や機動性の面を考慮してPhantom 4 Proを採用。ドローンにはテープでモーションキャプチャー用のカメラで読み込むためのマーカーが複数取り付けられている。

◉ドローンの動きを検出するモーションキャプチャーカメラ ▲今回はスタジオ内の飛行ルートに沿って、30台のモーションキャプチャーカメラ(OptiTrack Prime 41)を設置。最低4台のカメラがドローンに取り付けたマーカーを認識すれば、その動きを検出できるという。

▲今回はスタジオ内の飛行ルートに沿って、30台のモーションキャプチャーカメラ(OptiTrack Prime 41)を設置。最低4台のカメラがドローンに取り付けたマーカーを認識すれば、その動きを検出できるという。

重力の影響がある現実世界

飛行ルートはスタジオの設計図面をもとにCGソフト上にプレビスを制作。その中にドローンの軌跡を描いてカメラアングルまで決めてある。

「ただ、実際に現場で飛ばしてみると、カーブを描きながら飛ぶところが、だんだん外に膨らんだり、勝手に直進してしまったりして、それを修正するのに苦労しました(横山さん)」

その原因はドローンにかかる遠心力であったり、床に反射した照明の光がドローンの底面に搭載されているポジショニング用のビジョンセンサーを誤操作させたこと。さらに、テストでは問題がなく飛行しても、役者が入ると光の具合が変わって誤動作するといった問題もあった。そういった問題が起こるたびにプログラムを修正していくため、カメラテストは3日間にも及んだ。さらに、より人間の感性に近いカメラワークとするために、ドローンを手で持って撮影しながら、その軌跡を記録したり、人が手持ちできない条件ではマニュアルでドローンを飛ばしてカメラワークを記録したりするなどして調整していったという。

「CGで作ったカメラワークはやはり、どうしても機械的に見えてしまう部分もあるので、人間が撮影している距離感や温度感を表現しました(北田さん)」

PCとドローンの間にiPhoneを介するだけで、特別な改造や専用の機材を使うことなくドローンのモーションコントロールを実現した今回の作品。

「苦労した甲斐あって、ある程度技術のパッケージ化はできたと思います。今後はこのチームで複数台のドローンを使って撮影してみたいです(北田さん)」と次の作品への抱負を語ってくれた。

ドローンのモーションコントロールの概要

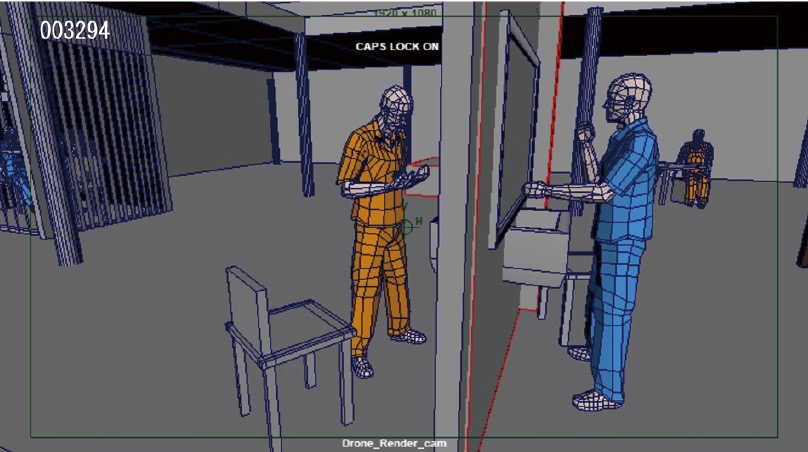

◉3DCGソフト・Mayaで撮影スタジオと同じ空間を再現

▲事前にMaya上で撮影スタジオと同じ空間・セットを再現したプレビズを制作。Mayaのカメラアニメーション機能を使用し、ドローンの軌道やカメラアングルもプレビズ上であらかじめ設計していった。

▲事前にMaya上で撮影スタジオと同じ空間・セットを再現したプレビズを制作。Mayaのカメラアニメーション機能を使用し、ドローンの軌道やカメラアングルもプレビズ上であらかじめ設計していった。

◉Mayaのデータを元にOptiTrackでドローンの動きを制御

▲ドローンの動きの検出と制御はOptiTrackのソフトウェアを使用。Mayaで作ったカメラの動きを読み込み、それをプログラミングでドローンに反映。撮影準備段階でうまく飛行できなかった部分は、手動でドローンを飛ばして、その場でモーションキャプチャーを行い、軌道の補正を行なった。

▲ドローンの動きの検出と制御はOptiTrackのソフトウェアを使用。Mayaで作ったカメラの動きを読み込み、それをプログラミングでドローンに反映。撮影準備段階でうまく飛行できなかった部分は、手動でドローンを飛ばして、その場でモーションキャプチャーを行い、軌道の補正を行なった。

◉ドローンによるモーションコントロール操作の仕組み

▲撮影中の模様。撮影は機材やセットの設置に1日、アングルチェックに3日、本番は1日半かけて実施されたという。

▲撮影中の模様。撮影は機材やセットの設置に1日、アングルチェックに3日、本番は1日半かけて実施されたという。

●ビデオSALON2019年4月号より転載