11月16日から18日の間、幕張メッセで開催された放送機器展・Inter BEE。アドビ システムズブースで行なわれたstoicsense(ストイックセンス)の東弘明(ひがし・ひろあき)さんのセッション「Intel x Adobe | VR制作事例」の模様をレポートする。セッション終了後に行なった東さんへのインタビューも掲載。

東 弘明●VFXディレクターを経て、2005年ディレクターへ転向。2013年stoicsense Incを設立。攻殻機動隊VRコンテンツ『VIRTUAL REALITY DIVER』、ソニー世界初立体視ミュージックビデオ『make.believe』、視野角180°ドックヤードプロジェクションマッピング、巨大LEDを使用したEXILE、L’Arc-en-Ciel、GLAYといったメジャーアーティストのLIVEオープニング映像など、体験型映像コンテンツの演出、CGプロデュースを手がける。

映像監督の東弘明と申します。私はミュージックビデオやコマーシャルの演出を始め、VR、3Dプロジェクションマッピング、ドーム映像といった体験型コンテンツの監督及びCGプロデュースを行なっております。

私は今、オリジナルVRコンテンツのプランニングを行なっていて、複数のCGプロダクションと一緒に動いています。先日ティザーがようやく完成しましたので、本日ここで披露したいと思います。では一度再生します。

実写とVFXを融合したVR・SFフィルムプロジェクト

『NEO ZIPANG』のティザームービー

Directed by HIROAKI HIGASHI (stoicsense)

produced by +Ring

music HIDEAKI TAKAHASHI

Planning stoicsense +Ring

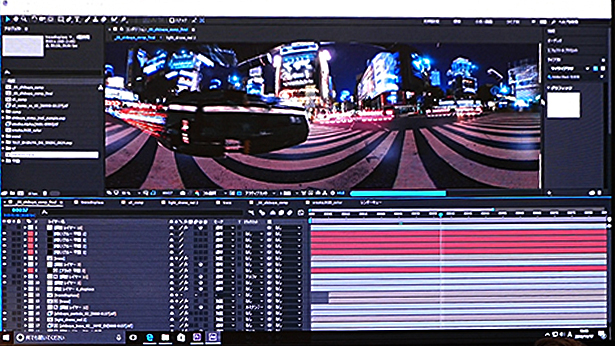

2つ前くらいのバージョンからPremiere上で360°映像を確認できるようになりました。本当に便利で良く使っています。Oculusへの送出にはサードパーティーのKolor Eyesというアプリを起動し、パソコンにOculusを挿して、360°VR映像を見ながら編集やカラコレなどの作業をしております。

▲Premiere Pro CCは2016年6月に行なわれたアップデート(2015.3)でVR動画の視聴とYouTubeにVR動画をアップロードするためのメタデータの追加機能を搭載した

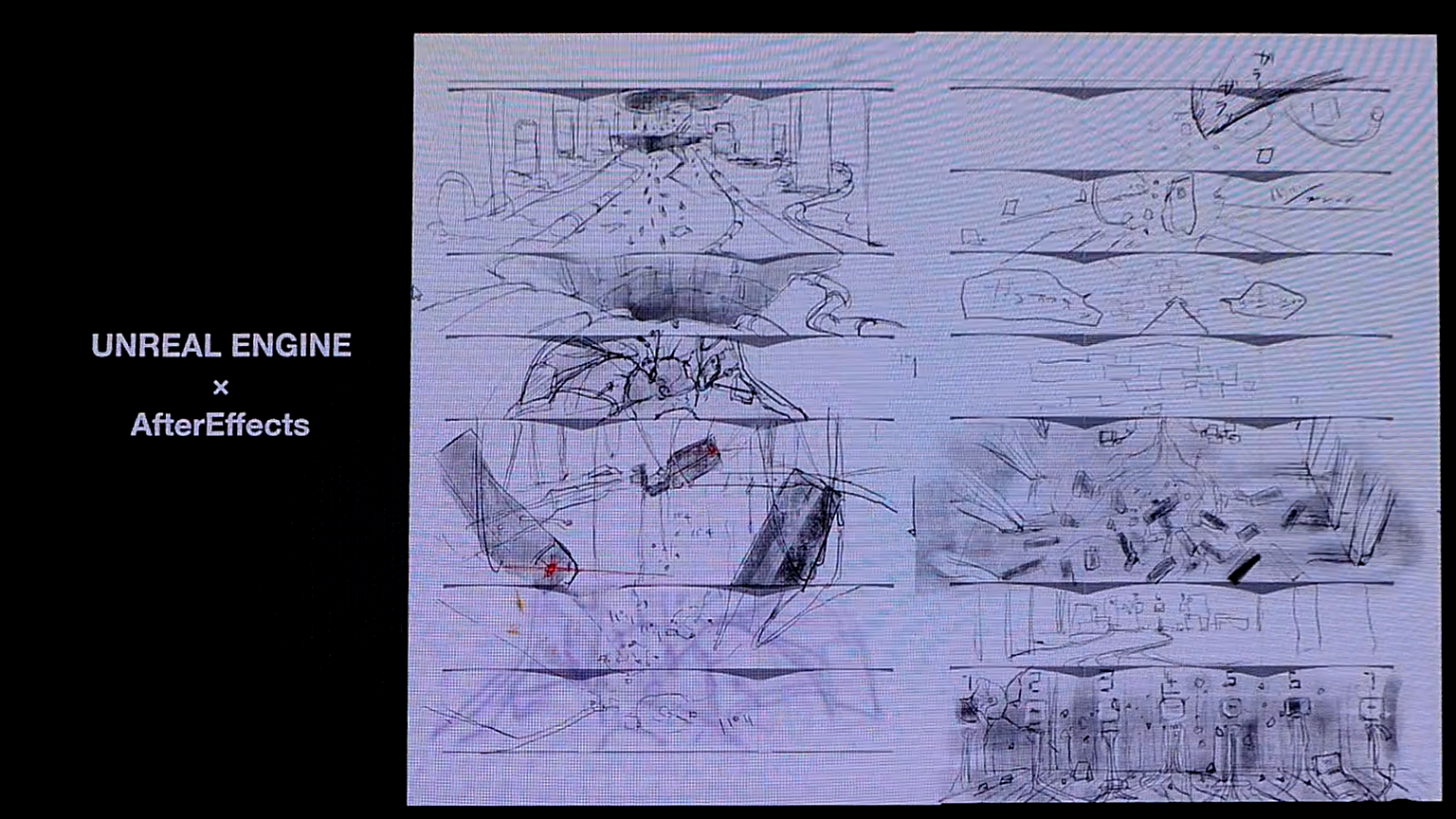

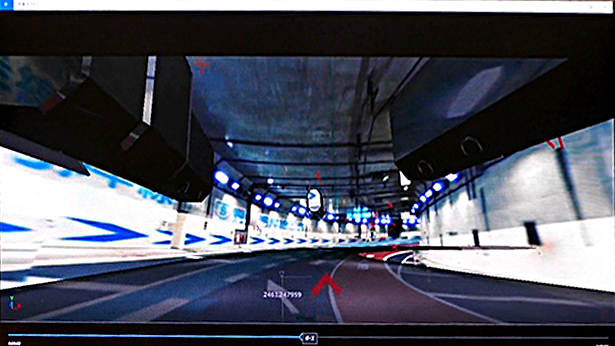

CGに関しては前半パートではUNREAL ENGINEを使って制作し、それを連番ファイルとして書き出し、After Effectsで合成、Premiereに持って来ています。

ちなみに会場で配られているVRのゴーグルのQRコードをスマホで読み込むとYouTubeのプレイリストが開かれ、このティザーを視聴することができます。是非とも見て頂けると嬉しいです。

▲当日、アドビブースで配布された紙製の簡易VRゴーグル。

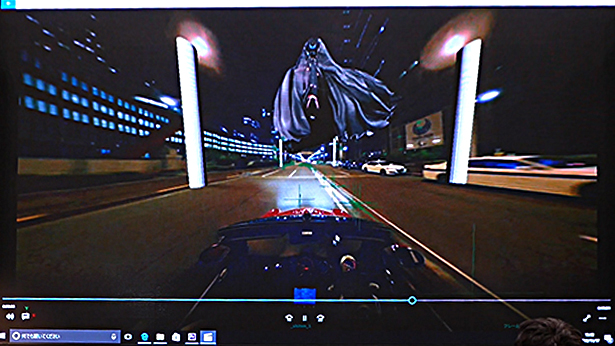

今作品は実写の360°映像にCGを合成した映像になります。ブラックマジックのカメラでリグを組み、撮影した映像をトラッキングしてAfter Effects上でコンポジットしています。

なぜ実写とCGのVR Filmを作りたいと思ったのか

今、私は「NEO ZIPANG」というプロジェクトを進めています。今日は20分位お時間を頂きましたので、何故こういったコンテンツを作りたいと思うに至ったか、という所からお話ししたいと思います。

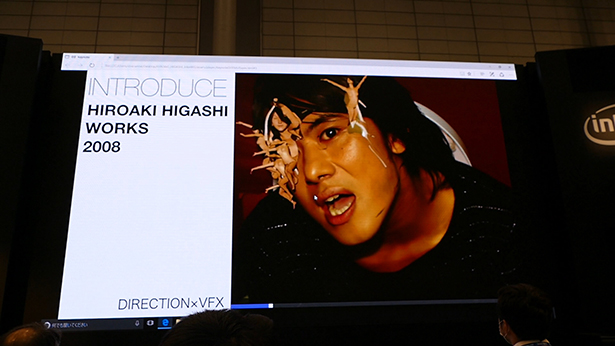

まず、簡単に自己紹介をしたいと思います。私はCGディレクターを経て、10年前に監督になりました。当時はミュージックビデオの演出、CG制作、グリーン抜き、合成までを全部一人で担当する…そんな映像制作を行なっていました。

このようなMVです。今はもう若くないので、こんな大変な事はもうできないんですが(笑)それから多くのデジタルアーティストと一緒に作るようになりました。こういった世界初の3Dミュージックビデオなども演出してきました。

▲ソニー世界初立体視ミュージックビデオ『make.believe』

そして3年前に法人化。stoicsenseという会社を立ち上げ、監督とプリビズ制作…CGのカメラワークですね、それを自社で制作、信頼できるデジタルアーティストにお渡しして、ショット制作をお願いする体制を構築していきました。

その頃から体験型のプロジェクションマッピングのような案件が増えていきました。

そして、こういったドーム映像ですね。この頃からVR案件のご相談が来るようになり、昨年『攻殻機動隊VR』の監督とCG制作総指揮を行ないました。ライド感のあるカメラワークの中でストーリーテリングの実現を目指したVRコンテンツになります。このティザーもYouTubeで視聴できます。攻殻機動隊 新劇場版 Virtual Reality Diver (公式ティザー映像・立体360°VR版)。

体験型のフルCGコンテンツの制作を終え、やはり私はミュージックビデオの演出、撮影を得意とするキャリアを生かして、「VR Film」…360°の実写映像をすごく撮りたいと感じました。今、世の中に出ているものは撮りっぱなしのVRコンテンツばかりであまり僕としては面白くない、だからVFXを織り交ぜた作品を日本のCGアーティスト達と一緒に作りたいと考えました。

そこで企画を考え、+Ringのプロデューサーに相談し、このプロジェクトが始まりました。同時にアドビの古田さんにこのプロジェクトのお話をして、ぜひ参加させて欲しいとのことで協賛を頂いて、今日私はここに立っているという流れになります。

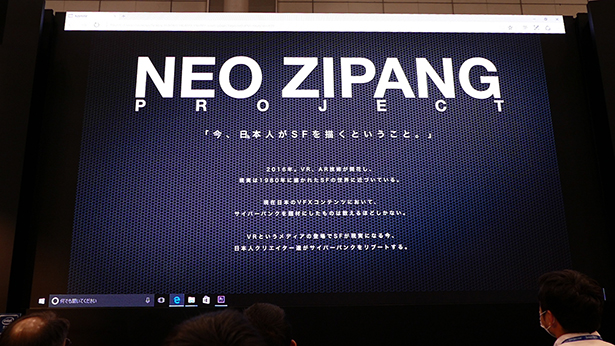

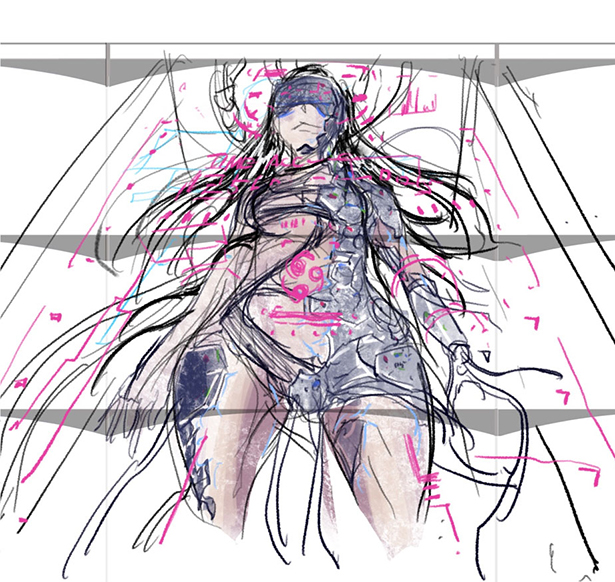

このNEO ZIPANGプロジェクトは、今この時代に、日本人だからこそ描くことができるSFがあるのではないか、という私の思いが込められています。本年はVR/AR元年と言われ、80年代に描かれたサイバーパンクの世界が現実になろうとしています。当時書かれた『ニューロマンサー』という小説は設定が日本なんですね。世界の極東で独自に発展したテクノロジーと文化。その中で産まれたサイバースペースという概念。その作品に皆が熱狂し『攻殻機動隊』だったり、『マトリックス』という良質なコンテンツが産まれたのですが、今日、日本人が描いたVFXコンテンツの中でサイバーパンクって本当に少なくて…こんなVR/ARの過渡期だからこそ、私達、日本のクリエイターがサイバーパンクのニュースタンダードを描くべきだと思ったのです。

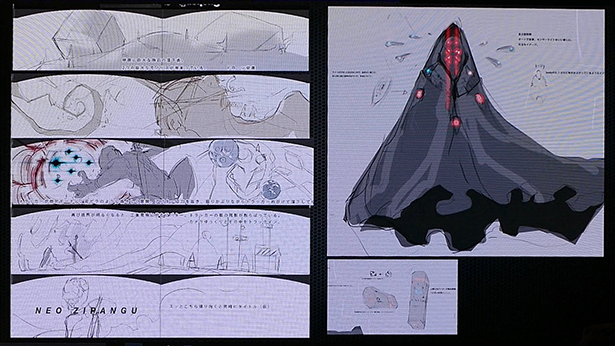

NEO ZIPANGの絵コンテ

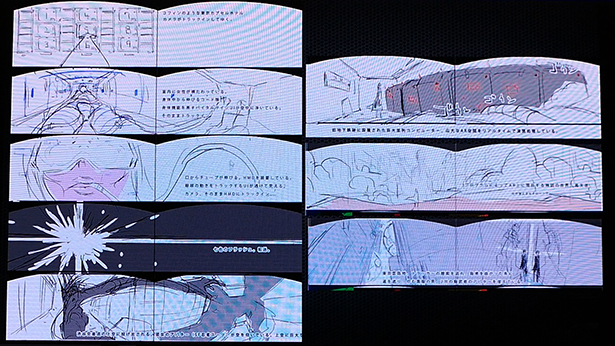

まずはティーザーオブティーザーを作ろうということになり、絵コンテを描き始めました。この頃は予算も何も決まってなく、本当に自由に絵コンテを切っていきました。

現代より少し先の東京を舞台にARバトルが行なわれる企画を考えていきました。

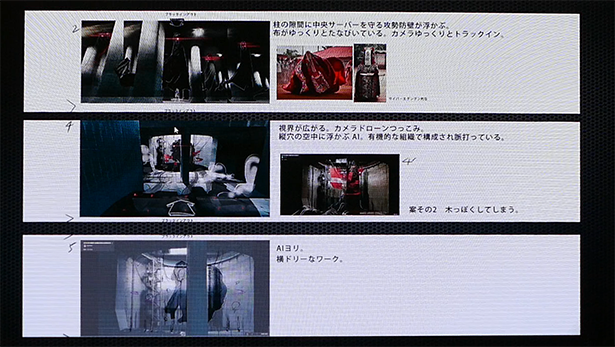

それから実際のロケ地なども想定し、コンテを描いていきました。最終的には、オープンカーにカメラを積み、手振れのない360°映像を撮って、そこにCGを合成していくという手法が現状でのベストという事になり、コンテを改定していきました。

フルCGパートはUNREAL ENGINEで制作

そして、VR撮影以外に今回チャレンジしたかったのが、ゲームエンジンを使用したVRムービーの制作でした。昨年『攻殻機動隊VR』を制作した際に、レンダリングにかかる時間とコストが非常に増大したため、制作体制をリアルタイムCGに移行するべきだと常々感じていました。クオリティーに関しても、Unity、UNREAL の描画はリアルタイムでありながらプリレンダーに非常に近づいて来ているので、今回実験的に、冒頭のCGのシーンを作る事にしました。UNREAL ENGINEからさまざまなパスを出して、After Effectsで組んでいくというワークフローを採用しました。

コンテで描いたコンセプトアートを、デジタルアーティストにUNREAL ENGINE上でモデル化してもらいました。

プリビズをMAYAで作り、ショットごとにCGアーティストに作り込んでもらう

次にメイキングですね。

まず撮影をしてカメラをトラッキングした後、私はプリビズの制作に入ります。これはMAYAというソフトを使って制作しているのですが、MAYAの中の天球に背景の映像を貼り付けて、トラッキングしたカメラデータを使って、ラフモデルをアニメーションさせていきます。こういったプリビズを一度作って、そのシーンをCGアーティストに渡して作り込んでもらいます。

実際はこんな感じでミニクーパーのカブリオレからカメラを突き出して撮っています。そして、この道路自体を3DCGで作り直し、After Effects上にレンダリングした連番を読み込んで、車を消すといった工程を+Ring のCGチームが行ないました。

では、After Effectsを立ち上げていきたいと思います。

このコンポ制作に関しても+Ringが行なっています。必要があればそのプロジェクトデータを頂いて、各レイヤーに私がカラコレを行なうというワークフローを取っています。最近私はAfter EffectsよりもPremiereでカラコレを行なうことが多くなってきています。特にプロジェクトが今回のように重い場合は、一度、Premiere上で調整レイヤーなどを使ってカラコレをしてから、そのエフェクトの載った調整レイヤーデータをAfter Effectsにコピペするというワークフローを取ってます。

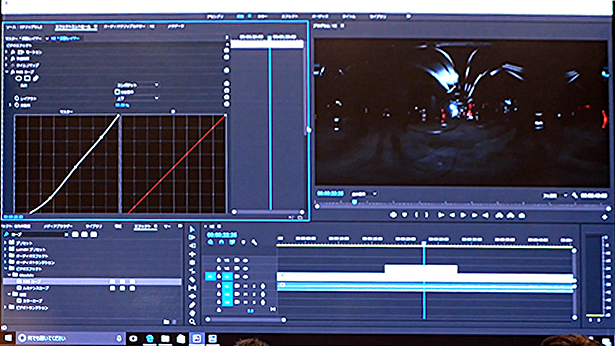

Premiereのすごいのはリアルタイムに再生しながらカラコレが可能なところ

このようにして調整レイヤーを使い、RGBカーブなどを載せてカラコレをしていくのですが、Premiereの凄い所はリアルタイムに再生しながらカラコレができるという点です。

映像を再生しながら、「前半と比べて後半の暗部を締めた方がいいかな」という具合に流れを見ながらカラコレが可能なんです。「少しハイにシアンを乗せてみようかな」とか「スキントーンをアンバーに寄せてみようかな」とか、ループ再生しながらRGBカーブを動かし、カラコレにアタリを付けることができます。

そしてGPUを使い、リアルタイムに重いエフェクトをかけられる点です。大抵私はSapphire(サファイア)というサードパーティーのプラグインでグローをかけ、一枚画として劇的な雰囲気になるように調整をしていきます。マスク機能で一部だけ明るくしたりしながら、視点誘導をしていきます。Photoshopで一枚画を詰めていくような感覚で絵作りをしていく、しかもそれを動画でできるという点が本当にPremiereの凄い所だと感じています。

マスクに関してもエフェクト毎にアサインできるので、「マスクを切って、周辺を落としてみよう」とか「グローのハイが飛び過ぎているので、このグローの部分だけマスクをかけて落としてみよう」といった事ができます。再生しながらマスクのボケ足の良い塩梅を探る事もできます。1カットに対してトーンカーブを3、4段使って、より画として美しく、かつ見易い、視点誘導された映像に仕上げていきます。 全体にざっくりカラコレをかけて終わっているTipsを良く目にしますが、現場ではもっと複雑な事が行なわれているのが常ですね。

このようにPremiereでカラコレを行ない、届かないところはAfter Effectsで細かく詰める、という流れにすると非常に効率的ですし、全体の色味に統一感が出て来ます。これをAfter Effectsだけで行なおうとすると、かなりの時間がかかってしまいます。

今一緒に仕事をしているコンポジターは、隣でSmokeやFlameを使用しているのですが、Premiereを見ながら、「これは本当にパワフルだね」と言われていて、ハイエンドなソフトウェアよりもレスポンシブにカラコレができるという印象を持たれていましたね。

そして、今回マウスコンピュータさんから提供して頂いたマシンが、インテルXeonデュアルプロセッサで48スレッド、NVIDIA Quadro P6000が載っているとんでもない化物みたいなマシンで、3K4Kの連番を何枚も重ねて、その上にサファイアを調整レイヤーで2段重ねても止まらないという…私は基本はMac Proで作業をしているのですが、これを機にWindowsに替えたいなと感じてしまう程でした。

ということで、まだまだ全然話し足りないのですが、お時間になってしまいました。ご清聴ありがとうございました!

セッション終了後に訊きました

●自主制作でVRコンテンツを作ろうと考えた理由を教えてください。

本年はVRの過渡期で、美しい風景をキレイに撮ってすごいねっていう時期がしばらく続いていたのですが、それも今や終わりに差し掛かっていて、今後VRがゲーム業界のみではなく、映像業界でも主流となるためには、やはり良質なコンテンツを作ることが一番大事だと感じていました。そういった意味でVFXを用いて、日本を舞台にしたSF作品をVRFilmで描くことができれば、それはマスターピースになるんじゃないかなと思ったんです。

ただ、まだインフラが整っていないこともあって、企画に対して予算がつかない。とはいっても今作らない理由がないですので、セルフプロデュースという形で企業が集まって、一緒にティザーを作り、投資を集め、さらに本格的に作っていこうという動きが起こりました。

太陽企画、+Ringのプロデューサーの大石さんと今年の春くらいから一緒に企画を始めて、来年明けからSIGGRAPH(シーグラフ)に向けて、10分くらいの予告編を予算をかけて作ろうとしています。なので今は、その脚本を執筆しています。

●VR映像のどういう部分に魅力を感じますか?

私はCGディレクターからキャリアが始まっているんですけど、MAYAというソフトを制作で使うんですね。空間の中に背景やキャラクターをレイアウトしたり、カメラワークを作っていったり…常に空間を意識した演出をCG、実写を問わず心掛けて来たので、そういった今までの自分のキャリアを一番生かせる媒体だなと感じています。舞台演出に近い感覚かもしれませんね。自分で全てをレイアウトした世界の中に入る事ができて、歩けて、いずれはそこで人とコミュニケーションもできる時代が来るかと思うと、すごく面白いですよね。自分で作った世界観に人を招き入れることができる。そこで起こる事件を一緒に見て、謎を一緒に解くとか…映像とゲームがすごくクロスしていくというか。

●ちょっと神様になった気分ですね(笑)

今はVRは1人でしか体験できないですけど、これが2人3人と同時に体験する事ができるようになり、インタラクティブになっていったら、凄い媒体に、、インフラになっていくんじゃないかなと思うんですよね。オリンピックの頃には、ヘッドマウントディスプレイもサングラスくらいのデバイスになっていて、それをつけたらオリンピックの会場にいるみたいな。そういう試みがパブリックビューイングでも現実になってくるんじゃないかなと思うんです。

●ストーリーテリングのあるVR映像を作られているとのことでしたが、通常の映像の場合とストーリーテリングの面でどんな違いがありますか?

通常の映像の文法がまったく使えないですよね。アングルという概念がない。基本すべてワンカットなんですよ。あまりカットを割ることは…まぁ、割ることはあるんですけど、少ないですね。ズームインしたり、クローズアップをインサートして心情を見せたりとかそういったことが全くできない。だからこそ、『攻殻機動隊VR』でストーリーテリングする時は、カメラワークを使って、心情を表現しようとしたんですね。ドラマが起きている時はダイナミックに回り込んで、感情の高ぶりを表現したり。そのカメラワークが激しすぎて、酔ってしまったというダメ出しも結構あったのですが(苦笑)それでも、音楽と完全シンクロした、気持ちのよい、カタルシスを感じられる演出に仕上がったと思っています。

●セッションではPremiereでの操作の快適さについてお話されていましたが、その他にAdobeのアップデートで便利に感じた点は?

今、VFX制作プロダクションのkhaki(カーキ)とよくお仕事をご一緒しているんですけど、多分この業界で一番スキルのある人が集まっている会社なんです。水野さんというInferno、Smokeエディターと田崎さん、横原さんという優秀なデジタルアーティストがいる会社なのですが、今見るコマーシャルとかで僕が「かっこいいな」って思う作品には大抵そこが噛んでますね。

そこに3日4日泊まり込みで、ずっと三代目J Soul Brothers のライブのオープニング映像を今作っていて、Cinema 4Dとの連携を初めて使ったんですけど、ヤバイですね。CGチームがトラッキングしたFBXデータが来るんですけど、After EffectsからバンドルのCinema 4D Liteを立ち上げて、FBXを読み込んでCinema 4Dファイルに書き出して保存すると、After Effectsが読み込んでくれて、めちゃくちゃ便利です。「東さん、知らないの?」って言われちゃって(笑)知らなかった…。あとは3Dモデルが読み込めたら完璧なんですけどね。それがマスクとして使えたりするといいですよね。

それから最近のアップデートで一番感動したのが、これまではPremiere Proタイムラインのトラック幅がずっと分厚かったんですよ。いつもPVのオフラインで90トラックくらい重ねるので、そうなった時には一度に表示するトラック数が少なくて苦労していたんですけど、最近のバージョンでは最小トラック幅が縮んで見やすくなったのが一番感動したかも(笑)。地味なネタですみません。

◆Inter BEEレポートをまとめて読む

http://www.genkosha.com/vs/report/interbee/