学校法人東放学園グループ5校は2025年9月27日、校内のスタジオから有観客ライブとYouTubeライブ配信で「VとRアニソンライブやってみた実習」を開催した。合同会社リフレクションのあくび氏指導のもと、東放学園グループの学生が、バーチャルシンガー(V)とリアルシンガー(R)が出演するアニソンライブの企画・制作・実施を通して、実践的な制作現場を体験するというもの。学生の興味として、アニソンやVTuberが高いということもあり、プロを育成してきたグループ5校の豊富な実習環境を最大限に活かし、「学校横断型カリキュラム」を実施していこうという試みとなった。

グループ5校は、東放学園音響専門学校、東放学園専門学校、東放学園映画アニメCG専門学校、 専門学校東京アナウンス学院、東放学園高等専修学校で、演者からCG制作、映像制作、照明、音響までが揃っていることで、各学校・学科の学生が自分の専門性(強み)を活かし、協力してひとつの実習課題に取り組むことができる。

授業としては、5月~9月の毎週土曜日、9月27日の本番を目指して準備していく。募集定員は70名で、144名の応募があり、抽選にて履修者確定は80名となったという。内訳としては、制作班14名/映像配信照明班35名/PA班10名/Singer班16名/VJ・CG班5名。

授業としては、制作班(音響芸術科、放送芸術科)、映像配信照明班(放送技術科、照明クリエイティブ科)、PA班(音響技術科)、CGVJ班(アニメCG科)、シンガー班(声優科、アナウンス科、配信クリエイター科)に分かれて実施。初回から7回目までは各班の職業理解をするために全班で授業を実施しマルチスキルを習得した。その後、イベント開催へ向けて各班で授業を行った。各班の連携は、Googleクラスルームや学生間のSNSグループで行なったという。

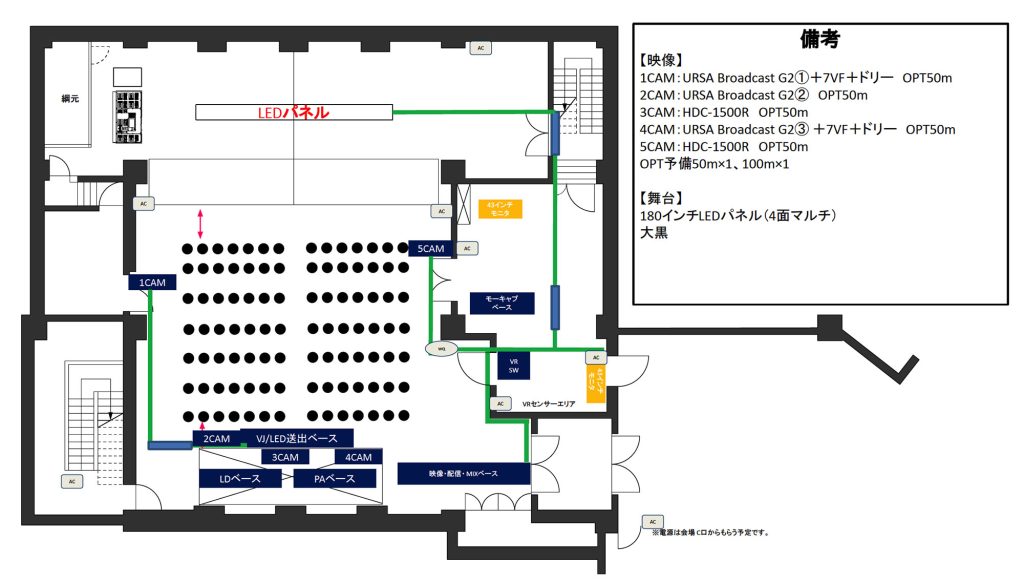

当日の会場図

学生が制作した映像系統図

映像配信班

- ライブスイッチャー:ATEM TelevisionStudioPro4K

- カメラ:BMD URSA BroadcastG2、SONY HDC-1500

- 配信システム:ATEM SDI ExtremeISO、Web presenter HD

- LEDパネル:スタンダード3.8mmPitch Airly Vision180インチ

- LEDプロセッサー:Novastar VX1000

照明班

- 照明操作ソフト:grand MA2

- 照明操作卓:MA Lighting MA2 onPC Command Wing

- 照明シミュレーションソフト:grand MA 3D、L8

- 照明機材:MAC Quantum Profile、MAC 700 Profile、Martin RUSH PAR、i-cove

PA班

- PAミキシングコンソール:YAMAHA CL5

- メインスピーカーシステム:JBL VT4889 + CSR82L 4/2

- メインパワーアンプ:CROWN IT4x3500HD + IT9000HD

バーチャル班

- バーチャルセット:Unreal Engine 5を使用し、美術セット・照明機材を設置

- バーチャルカメラ:HTC Vive Tracker2018をバーチャル内の手持ちカメラとして使用し、UE5内のカメラの動きと連動

技術協力:合同会社リフレクション

バーチャルステージ制作について

今回は本番時の安定性を確保するためバーチャルステージの歌唱パートを事前収録し、映像配信班に音声付き映像として納品。MCパートはリアルタイムモーションキャプチャーし、バーチャルステージとしてLEDパネルに表示している。

今回実習を行うスタジオの平面図面を基にモデリングソフトBlenderを使用して実寸で3Dモデルを制作し、Blender内でLEDビジョンと同サイズのオブジェクトを配置し、LEDビジョンに投影する部分、バーチャルカメラで映り込む部分をそれぞれ考慮しながらおおよそのライトの位置やトラスの配置を行なった。作成したモデルをfbxでUnreal Engine5にインポートしてアセットとして使用し、シネカメラアクタでLED投影アングルを作成したという。

バーチャルシンガー周りの照明について

照明信号も事前に収録する必要があるが、楽曲に合わせて学生が打ち込みを行い、その照明信号をUnreal Engineに収録することでシーケンスの再生に対応した。バーチャルシンガーに安定して照明を当てるために追従ライトと、不自然な影を消すためのフラットライトを配置しており、追従ライトはシネカメラの追従機能を使い常にバーチャルシンガーを追従させ常に同じ光量で当て続けるようにしている。

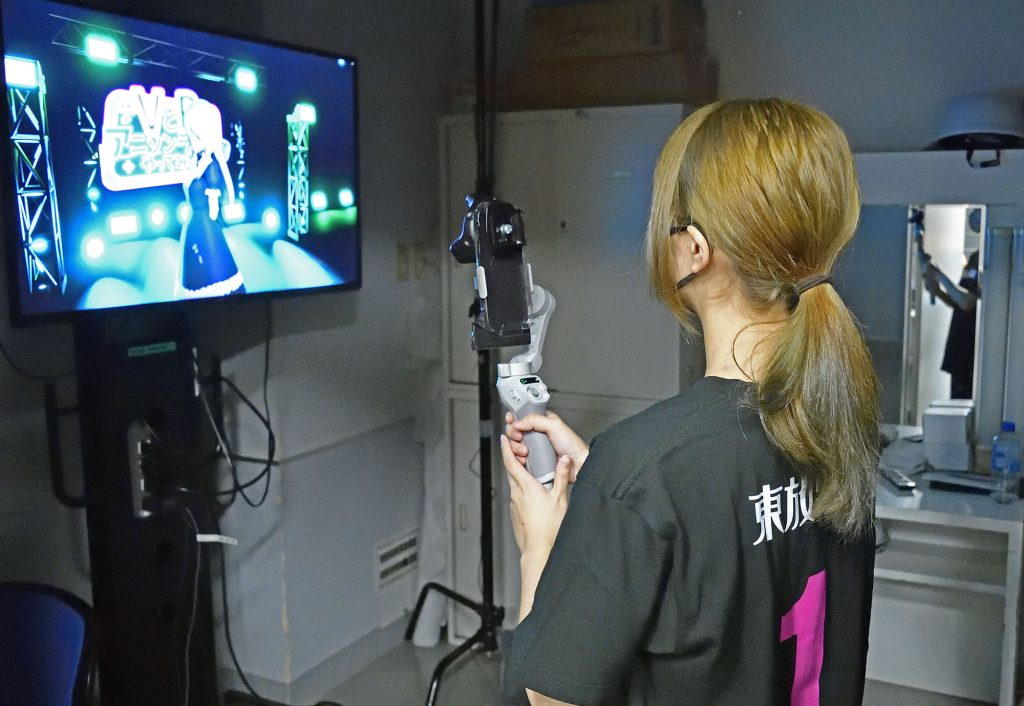

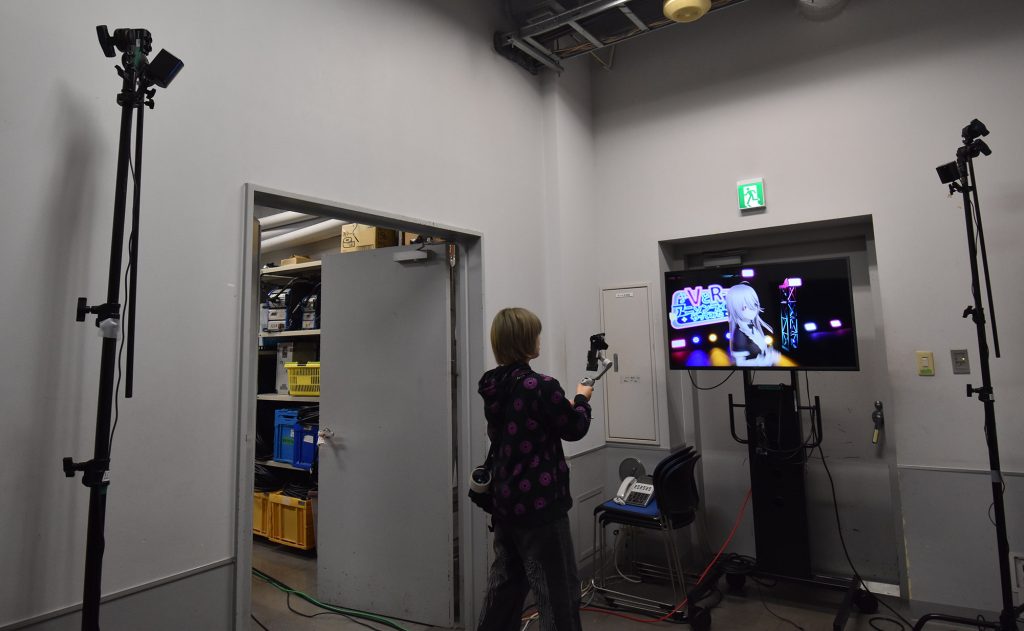

バーチャルカメラの実装について

MCパートでバーチャルシンガーがトークする部分はステージ横にブースを設け、リアルタイムで手持ちカメラやバーチャルスイッチングカメラのためにUnreal Engineのブループリントを使用してカメラの切り替えや追従設定などを実装した。バーチャルカメラはHTC Vive Trackerを使用し、バーチャル空間内のカメラ位置と同期、トラッカーをジンバルに取り付け、スムーズさ、手ブレの軽減に使用した。

またバーチャルカメスイッチングにはStreamDeckを使用し、キーボードのキーアサインでカメラを切り替えできるようにし、直感的にスイッチングできる環境を整えた。

キャラクター制作からバーチャルシンガー制作のワークフローについて(東放学園映画アニメCG専門学校 教務教育部・景利康弘氏レポートより抜粋)

キャラクター制作からどうやってモーションをつけバーチャルシンガーとしてLEDパネルに投影したのかは以下のとおり。

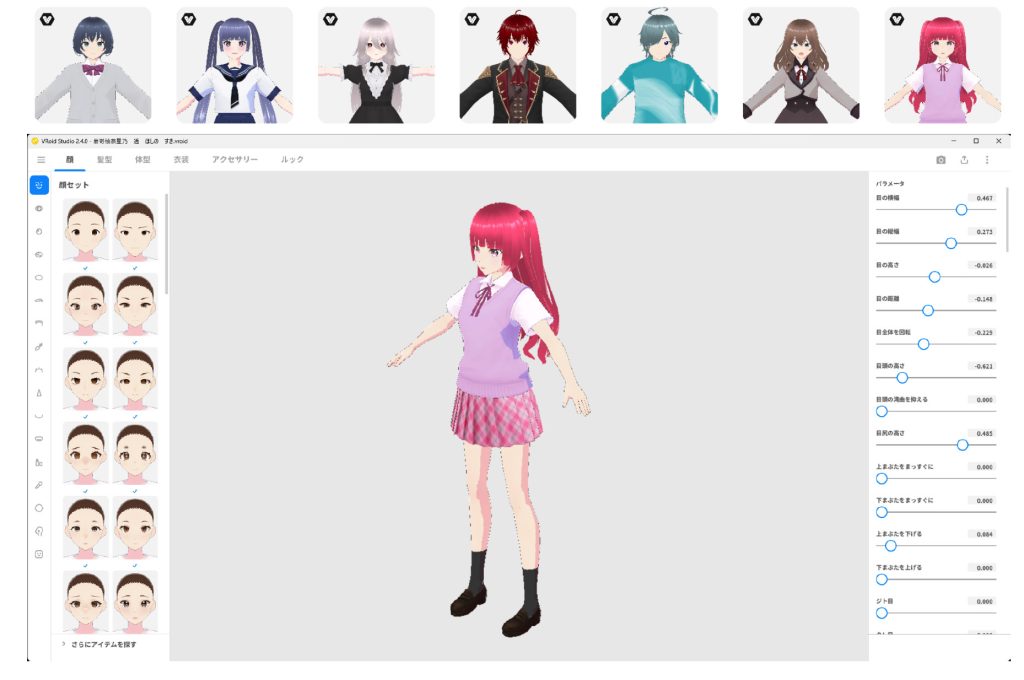

デザインおよびモデル制作はVRoid Studioを使用し、バーチャル・シンガー班の学生が自ら制作。この段階でキャラクターネーム(本人ではなくバーチャル・シンガーとして登場するため)も命名している。

モーション収録は楽曲、振り付け決定後、V班メンバーがアクターを務め、アナウンス学院所有のモーションキャプチャシステム「Perception Neuron」で収録。モーションデータはFBX形式で共有。

楽曲収録は、同じく、東京アナウンス学院のスタジオで歌唱を収録。

UnrealEngine上でのキャラクターモーション再生の手法検討した。

最終的な制作フローとしては以下になる。

VRoid Studio:VRM形式でモデルエクスポート

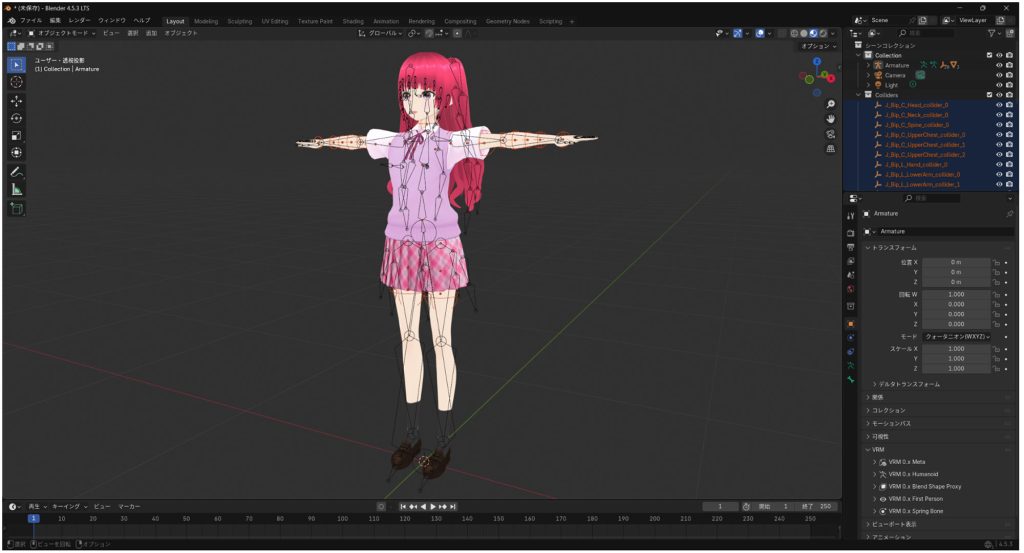

Blender:VRM Add-on for BlendeでVRMをインポート、FBX形式でエクスポート

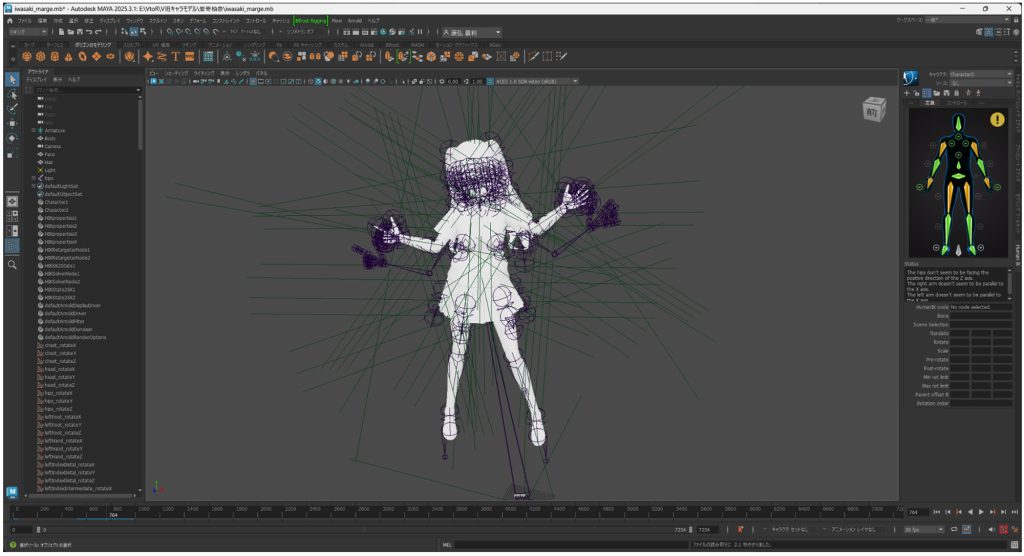

maya:HumanIKでモデルとモーションをリターゲット

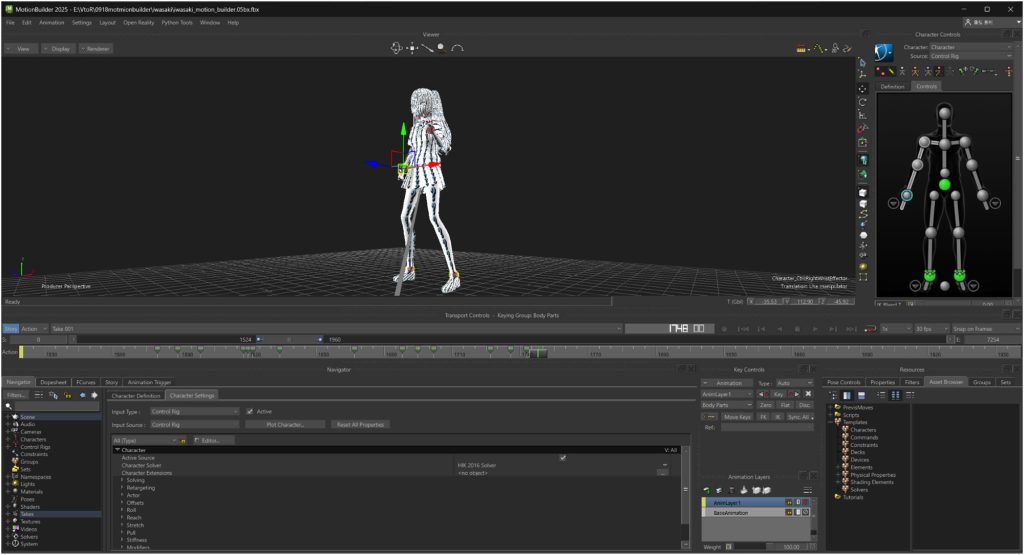

Motion Builder:mayaのシーンを同期した上で、アニメーションレイヤーでめり込みの修正。FBX形式で保存

①ステージ上LEDパネルに上映する映像(事前収録)および配信画面に出すヴァーチャルカメラ映像はUnrealEngine5.5.4(ヴァーチャル照明班があらかじめこのバージョンでステージ、照明環境を構築しており、それに合わせたもの):

VRM4UでVRMをインポート、MotionBuilderからのFBXもインポート。FBXのモデルはマテリアルが崩れているので、VRM側からFBX側にテクスチャをコピーして再生。このデータをステージに配置、バーチャル照明下でのライブ映像の収録、及び、配信時のバーチャル照明に利用している。

②ステージ上でのMCとのやり取り、及びコーナー時の、リアルタイム映像は、①で読み込んだVRMを、mocopi Receiver Plugin for Unreal Engineを使用してリターゲット、別室でのアクターの動きを、リアルタイムにステージに反映した。

mocopi proを使った12点トラッキング、センサーデータレシーバーを経したPC版mocopiアプリの使用も検討されたが、最終的には取り回しの簡便さから、スマホ版mocopiアプリを使用。3台のiPadProにアプリをインストールし、別ポートから信号を読み込ませている。

「VとRアニソンライブやってみた実習」当日の模様

映像遅延対策としては、映像、音声、バーチャルシンガー映像の遅延を解消するためにPAやMIXにおいてディレイを入れて対応した。初の試みとして、いくつか技術的な課題は残ったが、よりクオリティの高いものを目指し、構想全体を3段階として2年目は初年度と比較し技術の向上を目指すとしている。